Difference between revisions of "Big data"

Onnowpurbo (talk | contribs) |

Onnowpurbo (talk | contribs) |

||

| (15 intermediate revisions by the same user not shown) | |||

| Line 1: | Line 1: | ||

Sumber: https://en.wikipedia.org/wiki/Big_data | Sumber: https://en.wikipedia.org/wiki/Big_data | ||

| + | [[Image:Hilbert InfoGrowth.png|right|200px|thumb]] | ||

| − | + | Data besar adalah istilah yang luas untuk data set begitu besar atau kompleks bahwa aplikasi pengolahan data tradisional tidak memadai. Tantangan meliputi analisis, capture, data kurasi, pencarian, berbagi, penyimpanan, transfer, visualisasi, dan privasi informasi. Istilah sering merujuk hanya untuk penggunaan analisis prediktif atau metode canggih tertentu lainnya untuk mengekstrak nilai dari data, dan jarang untuk ukuran tertentu kumpulan data. Akurasi data besar dapat menyebabkan pengambilan keputusan yang lebih percaya diri. Dan keputusan yang lebih baik dapat berarti efisiensi operasional yang lebih besar, pengurangan biaya dan mengurangi risiko. | |

| − | + | Analisis data set dapat menemukan korelasi baru, untuk "tren bisnis spot, mencegah penyakit, kejahatan tempur dan sebagainya." Para ilmuwan, eksekutif bisnis, praktisi media dan periklanan dan pemerintah sama-sama secara teratur bertemu kesulitan dengan set data yang besar di topik termasuk pencarian Internet, keuangan dan usaha informatika. Para ilmuwan menemukan keterbatasan dalam pekerjaan e-Science, termasuk meteorologi, genomik, connectomics, simulasi fisika kompleks, dan penelitian biologi dan lingkungan. | |

| − | Data | + | Data set tumbuh dalam ukuran sebagian karena mereka semakin sering dikumpulkan oleh perangkat murah dan banyak informasi-sensing mobile, udara (penginderaan jarak jauh), log software, kamera, mikrofon, identifikasi frekuensi radio (RFID) pembaca, dan jaringan sensor nirkabel. Teknologi kapasitas per-kapita di dunia untuk menyimpan informasi telah kira-kira dua kali lipat setiap 40 bulan sejak tahun 1980-an; pada 2012, setiap hari 2,5 exabyte (2,5 × 1018) data diciptakan; Tantangan bagi perusahaan besar adalah menentukan siapa yang harus memiliki inisiatif data besar yang mengangkang seluruh organisasi. |

| − | + | Bekerja dengan data besar adalah tentu jarang; kebanyakan analisis dari "ukuran PC" data, pada PC desktop atau notebook yang dapat menangani set data yang tersedia. | |

| − | + | Sistem manajemen database relasional dan statistik komputer desktop dan paket visualisasi sering mengalami kesulitan menangani data besar. Pekerjaan tersebut membutuhkan "perangkat lunak berjalan secara paralel yang masif pada puluhan, ratusan, atau bahkan ribuan server". Apa yang dianggap "big data" bervariasi tergantung pada kemampuan pengguna dan alat-alat mereka, dan kemampuan memperluas membuat Big Data target bergerak. Jadi, apa yang dianggap "besar" satu tahun menjadi biasa. "Untuk beberapa organisasi, menghadapi ratusan gigabyte data untuk pertama kalinya dapat memicu kebutuhan untuk mempertimbangkan kembali pilihan manajemen data. Bagi yang lain, mungkin diperlukan puluhan atau ratusan terabyte sebelum ukuran data menjadi pertimbangan yang signifikan." | |

| + | |||

| + | |||

| + | ==Pengalaman Buruk== | ||

| + | |||

| + | Pengalaman buruk dengan big data, terutama dengan Hadoop yang pada dasarnya adalah sebuah sistem operasi / file system di atas sistem operasi yang ada. Hadoop ini sangat rentan pada listrik. Kalau sampai listrik mati mendadak dan kita tidak mematikan Hadoop, maka kemungkinan besar data akan corrupt dan hilang. Sebaiknya kalau mainan big data pastikan komputer tidak sampai mati, supaya hidup anda lebih aman. | ||

| Line 18: | Line 24: | ||

* https://en.wikipedia.org/wiki/Big_data | * https://en.wikipedia.org/wiki/Big_data | ||

* http://jawdat.com/id/video-material-hackathon/ | * http://jawdat.com/id/video-material-hackathon/ | ||

| + | |||

| + | |||

| + | ==Pranala Menarik== | ||

| + | |||

| + | * [[Apa Itu Big Data?]] | ||

| + | * [[Apa Itu Machine Learning?]] | ||

| + | * [[Apa Itu Data Mining?]] | ||

| + | * [[Big Data: Top 10 Tool]] | ||

| + | * [[Apache: Hadoop]] '''COOL''' | ||

| + | * [[Big Data: 8 Trend]] | ||

| + | * [[Langkah untuk Memaksimalkan Strategi Potensial Big Data]] | ||

| + | * [[3 Tip Untuk Memaksimalkan Manfaat Data Anda di Big Data]] | ||

| + | * [[Big Data: Tiga Keuntungan Utama Big Data]] | ||

| + | * [[Big Data: Ancaman atau Kesempatan? Big Data dan Cyber Security]] | ||

| + | * [[BIg Data: Sepuluh Keuntungan Utama Data Mining]] | ||

| + | * [[Apa Itu Big Data? Mengapa Itu Penting?]] | ||

Latest revision as of 06:03, 18 February 2023

Sumber: https://en.wikipedia.org/wiki/Big_data

Data besar adalah istilah yang luas untuk data set begitu besar atau kompleks bahwa aplikasi pengolahan data tradisional tidak memadai. Tantangan meliputi analisis, capture, data kurasi, pencarian, berbagi, penyimpanan, transfer, visualisasi, dan privasi informasi. Istilah sering merujuk hanya untuk penggunaan analisis prediktif atau metode canggih tertentu lainnya untuk mengekstrak nilai dari data, dan jarang untuk ukuran tertentu kumpulan data. Akurasi data besar dapat menyebabkan pengambilan keputusan yang lebih percaya diri. Dan keputusan yang lebih baik dapat berarti efisiensi operasional yang lebih besar, pengurangan biaya dan mengurangi risiko.

Analisis data set dapat menemukan korelasi baru, untuk "tren bisnis spot, mencegah penyakit, kejahatan tempur dan sebagainya." Para ilmuwan, eksekutif bisnis, praktisi media dan periklanan dan pemerintah sama-sama secara teratur bertemu kesulitan dengan set data yang besar di topik termasuk pencarian Internet, keuangan dan usaha informatika. Para ilmuwan menemukan keterbatasan dalam pekerjaan e-Science, termasuk meteorologi, genomik, connectomics, simulasi fisika kompleks, dan penelitian biologi dan lingkungan.

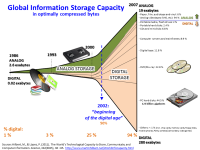

Data set tumbuh dalam ukuran sebagian karena mereka semakin sering dikumpulkan oleh perangkat murah dan banyak informasi-sensing mobile, udara (penginderaan jarak jauh), log software, kamera, mikrofon, identifikasi frekuensi radio (RFID) pembaca, dan jaringan sensor nirkabel. Teknologi kapasitas per-kapita di dunia untuk menyimpan informasi telah kira-kira dua kali lipat setiap 40 bulan sejak tahun 1980-an; pada 2012, setiap hari 2,5 exabyte (2,5 × 1018) data diciptakan; Tantangan bagi perusahaan besar adalah menentukan siapa yang harus memiliki inisiatif data besar yang mengangkang seluruh organisasi.

Bekerja dengan data besar adalah tentu jarang; kebanyakan analisis dari "ukuran PC" data, pada PC desktop atau notebook yang dapat menangani set data yang tersedia.

Sistem manajemen database relasional dan statistik komputer desktop dan paket visualisasi sering mengalami kesulitan menangani data besar. Pekerjaan tersebut membutuhkan "perangkat lunak berjalan secara paralel yang masif pada puluhan, ratusan, atau bahkan ribuan server". Apa yang dianggap "big data" bervariasi tergantung pada kemampuan pengguna dan alat-alat mereka, dan kemampuan memperluas membuat Big Data target bergerak. Jadi, apa yang dianggap "besar" satu tahun menjadi biasa. "Untuk beberapa organisasi, menghadapi ratusan gigabyte data untuk pertama kalinya dapat memicu kebutuhan untuk mempertimbangkan kembali pilihan manajemen data. Bagi yang lain, mungkin diperlukan puluhan atau ratusan terabyte sebelum ukuran data menjadi pertimbangan yang signifikan."

Pengalaman Buruk

Pengalaman buruk dengan big data, terutama dengan Hadoop yang pada dasarnya adalah sebuah sistem operasi / file system di atas sistem operasi yang ada. Hadoop ini sangat rentan pada listrik. Kalau sampai listrik mati mendadak dan kita tidak mematikan Hadoop, maka kemungkinan besar data akan corrupt dan hilang. Sebaiknya kalau mainan big data pastikan komputer tidak sampai mati, supaya hidup anda lebih aman.

Referensi

Pranala Menarik

- Apa Itu Big Data?

- Apa Itu Machine Learning?

- Apa Itu Data Mining?

- Big Data: Top 10 Tool

- Apache: Hadoop COOL

- Big Data: 8 Trend

- Langkah untuk Memaksimalkan Strategi Potensial Big Data

- 3 Tip Untuk Memaksimalkan Manfaat Data Anda di Big Data

- Big Data: Tiga Keuntungan Utama Big Data

- Big Data: Ancaman atau Kesempatan? Big Data dan Cyber Security

- BIg Data: Sepuluh Keuntungan Utama Data Mining

- Apa Itu Big Data? Mengapa Itu Penting?