Difference between revisions of "Keras: Python Keras Text Classification"

Onnowpurbo (talk | contribs) |

Onnowpurbo (talk | contribs) |

||

| (36 intermediate revisions by the same user not shown) | |||

| Line 176: | Line 176: | ||

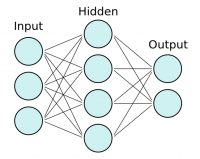

[[File:Ann.png|center|200px|thumb]] | [[File:Ann.png|center|200px|thumb]] | ||

| + | Kita mulai dengan memiliki lapisan neuron input tempat kita memberi masukan di feature vector kita dan nilai tersebut kemudian diumpankan (feed forward) ke lapisan tersembunyi. Pada setiap koneksi, kita memasukan nilai untuk dimajukan, kemudian nilai dikalikan dengan bobot dan ditambahkan bias. Ini terjadi pada setiap koneksi dan pada akhirnya kita mencapai lapisan output dengan satu atau lebih node output. | ||

| − | + | Jika kita ingin memiliki klasifikasi biner, kita dapat menggunakan satu simpul, tetapi jika kita memiliki beberapa kategori, kita harus menggunakan banyak simpul untuk setiap kategori. | |

| − | + | Kita dapat memiliki lapisan tersembunyi sebanyak yang kita inginkan. Sebetulnya, neural networks dengan lebih dari satu lapisan tersembunyi dianggap sebagai deep neural networks. Jangan khawatir: kita tidak akan sampai di sini ke kedalaman matematika tentang neural network. Tetapi jika kita ingin mendapatkan pemahaman visual intuitif tentang matematika yang terlibat, anda dapat melihat Playlist YouTube https://www.youtube.com/playlist?list=PLZHQObOWTQDNU6R1_67000Dx_ZCJB-3pi oleh Grant Sanderson. Rumus dari satu layer ke yang berikutnya adalah persamaan pendek ini: | |

| − | |||

| − | |||

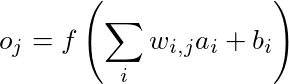

| − | + | [[File:Rumus-neural-network.png|center|400px|thumb]] | |

| − | |||

| − | |||

| − | + | Mari kita perlahan membongkar apa yang terjadi di sini. Kita lihat, kita berurusan di sini hanya dengan dua lapisan. Layer dengan node a berfungsi sebagai input untuk layer dengan node o. Untuk menghitung nilai untuk setiap simpul keluaran, kita harus mengalikan setiap simpul masukan dengan bobot w dan menambahkan bias b. | |

| − | + | Semua itu harus dijumlahkan dan diteruskan ke fungsi f. Fungsi ini dianggap sebagai fungsi aktivasi dan ada berbagai fungsi berbeda yang dapat digunakan tergantung pada lapisan atau masalahnya. Umumnya umum untuk menggunakan rectified linear unit (ReLU) untuk lapisan hidden, fungsi sigmoid untuk lapisan output dalam masalah klasifikasi biner, atau fungsi softmax untuk lapisan output dari masalah klasifikasi multi-kelas. | |

| − | + | Kita mungkin sudah bertanya-tanya bagaimana bobot dihitung, dan ini jelas merupakan bagian terpenting dari neural networks, tetapi juga bagian yang paling sulit. Algoritma dimulai dengan menginisialisasi bobot dengan nilai acak dan mereka kemudian dilatih dengan metode yang disebut backpropagation. | |

| − | + | Ini dilakukan dengan menggunakan metode optimisasi (juga disebut optimizer) seperti gradient descent untuk mengurangi kesalahan antara output yang dihitung dan yang diinginkan (juga disebut output target). Kesalahan ditentukan oleh fungsi kerugian (loss function) yang kerugiannya (loss-nya) ingin kami perkecil dengan optimizer. Seluruh proses terlalu luas untuk dibahas di sini, tetapi saya akan merujuk lagi ke playlist Grant Sanderson dan buku Deep Learning oleh Ian Goodfellow. | |

| − | + | Yang harus kita ketahui adalah bahwa ada berbagai metode pengoptimalan yang dapat kita gunakan, tetapi pengoptimal yang paling umum saat ini digunakan adalah Adam yang memiliki kinerja yang baik dalam berbagai masalah. | |

| − | + | Kita juga dapat menggunakan fungsi loss yang berbeda, tetapi dalam tutorial ini kita hanya akan memerlukan cross entropy loss function atau lebih khusus, binary cross entropy yang digunakan untuk masalah klasifikasi biner. Pastikan untuk bereksperimen dengan berbagai metode dan tool yang tersedia. Beberapa peneliti bahkan mengklaim dalam sebuah artikel baru-baru ini bahwa pilihan untuk metode berkinerja terbaik berbatasan dengan alchemy. Alasannya adalah bahwa banyak metode tidak dijelaskan dengan baik dan terdiri dari banyak penyesuaian dan testing. | |

| − | |||

| − | Keras | + | ==Pengenalan Keras== |

| − | + | Keras adalah pembelajaran mendalam dan API neural networks oleh François Chollet yang mampu berjalan di atas Tensorflow (Google), Theano atau CNTK (Microsoft). Mengutip buku bagus dari François Chollet, Deep Learning with Python: | |

| − | + | ''"Keras is a model-level library, providing high-level building blocks for developing deep-learning models. It doesn’t handle low-level operations such as tensor manipulation and differentiation. Instead, it relies on a specialized, well-optimized tensor library to do so, serving as the backend engine of Keras (Source)"'' | |

| − | |||

| − | + | Ini adalah cara yang bagus untuk mulai bereksperimen dengan neural network tanpa harus menerapkan setiap lapisan oleh kita sendiri. Misalnya Tensorflow adalah library machine learning yang hebat, tetapi kita harus menerapkan banyak kode boilerplate agar model bisa jalan. | |

| − | + | ==Install Keras== | |

| − | + | Sebelum menginstall Keras, kita perlu Tensorflow, Theano, atau CNTK. Dalam tutorial ini kita akan menggunakan Tensorflow jadi lihat panduan instalasi mereka, tetapi jangan ragu untuk menggunakan salah satu framework yang paling cocok untuk anda. Keras dapat diinstal menggunakan PyPI dengan perintah berikut: | |

| − | $ | + | $ pip install keras |

| − | + | Kita dapat memilih backend yang ingin kita miliki dengan membuka file konfigurasi Keras yang dapat kita temukan di sini: | |

| − | + | $HOME/.keras/keras.json | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Jika anda adalah pengguna Windows, anda harus mengganti $HOME dengan %USERPROFILE%. File konfigurasi akan terlihat sebagai berikut: | |

| − | + | { | |

| − | + | "image_data_format": "channels_last", | |

| + | "epsilon": 1e-07, | ||

| + | "floatx": "float32", | ||

| + | "backend": "tensorflow" | ||

| + | } | ||

| − | + | Kita dapat mengubah backend field menjadi "theano", "tensorflow" atau "cntk", mengingat kita telah menginstal backend pada mesin yang kita gunakan. Untuk lebih jelasnya lihat dokumentasi Keras backends. | |

| − | + | Anda mungkin memperhatikan bahwa kita menggunakan data float32 dalam file konfigurasi. Alasan untuk ini adalah bahwa neural network sering digunakan dalam GPU, dan hambatan komputasi adalah memori. Dengan menggunakan 32 bit, kita dapat mengurangi beban memori dan kami tidak kehilangan terlalu banyak informasi dalam proses. | |

| − | + | ==Model Keras anda yang pertama== | |

| − | + | Sekarang kita akhirnya siap untuk bereksperimen dengan Keras. Keras mendukung dua (2) jenis utama model. Kita memiliki API model Sequential yang akan kita lihat digunakan dalam tutorial ini dan API fungsional yang dapat melakukan semua hal dari model Sequential tetapi dapat juga digunakan untuk model lanjutan dengan arsitektur jaringan yang kompleks. | |

| − | + | Model Sequential adalah tumpukan linear lapisan, di mana kita dapat menggunakan berbagai macam lapisan yang tersedia di Keras. Lapisan yang paling umum adalah lapisan Dense yang merupakan lapisan neural network biasa yang terhubung dengan semua Weight dan bias yang sudah kita kenal. | |

| − | |||

| − | + | Mari kita lihat apakah kita dapat mencapai beberapa peningkatan pada model regresi logistik kita sebelumnya. Anda dapat menggunakan array X_train dan X_test yang Anda buat dalam contoh kami sebelumnya. | |

| − | + | Sebelum kita membangun model kita, kita perlu mengetahui dimensi input vektor fitur kita. Ini hanya terjadi di lapisan pertama karena lapisan berikut dapat melakukan inferensi shape secara otomatis. Untuk membangun model Sequential, kita dapat menambahkan layer satu per satu dengan urutan sebagai berikut: | |

| − | |||

| − | |||

| − | |||

| − | + | from keras.models import Sequential | |

| + | from keras import layers | ||

| + | |||

| + | input_dim = X_train.shape[1] # Number of features | ||

| + | |||

| + | model = Sequential() | ||

| + | model.add(layers.Dense(10, input_dim=input_dim, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| − | + | ==Penggunaan backend TensorFlow== | |

| − | + | Sebelum kita dapat mulai dengan training model, kita harus mengonfigurasi proses training. Ini dilakukan dengan metode .compile(). Metode ini menentukan fungsi optimizer dan loss. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Selain itu, kita dapat menambahkan daftar metrik yang nantinya dapat digunakan untuk evaluasi, tetapi mereka tidak memengaruhi training. Dalam hal ini, kita ingin menggunakan binary cross entropy dan Adam optimizer yang kita lihat dalam bagian sebelumnya. Keras juga mencakup fungsi .summary() yang berguna untuk memberikan gambaran umum tentang model dan jumlah parameter yang tersedia untuk training: | |

| − | + | model.compile(loss='binary_crossentropy', | |

| + | optimizer='adam', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| + | |||

| + | Hasilnya | ||

| + | _________________________________________________________________ | ||

| + | Layer (type) Output Shape Param # | ||

| + | ================================================================= | ||

| + | dense_1 (Dense) (None, 10) 17150 | ||

| + | _________________________________________________________________ | ||

| + | dense_2 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 17,161 | ||

| + | Trainable params: 17,161 | ||

| + | Non-trainable params: 0 | ||

| + | _________________________________________________________________ | ||

| + | |||

| + | Anda mungkin memperhatikan bahwa kita memiliki 8575 parameter untuk lapisan pertama dan 6 lainnya di lapisan berikutnya. Dari mana datangnya? | ||

| + | |||

| + | Lihat, kita memiliki 1714 dimensi untuk setiap feature vector, dan kemudian kita memiliki 5 node. Kita perlu bobot untuk setiap dimensi feature dan setiap node yang menyumbang 1714 * 5 = 8570 parameter, dan kemudian kita memiliki 5 kali bias tambahan untuk setiap node, yang memberi kita 8575 parameter. Pada node terakhir, kita memiliki 5 bobot dan satu bias, yang membawa kita ke 6 parameter. | ||

| − | + | Kita hampir sampai. Sekarang saatnya untuk memulai training dengan fungsi .fit(). | |

| − | + | Karena training dalam neural network adalah proses berulang, training tidak akan berhenti setelah selesai. Kita harus menentukan jumlah iterasi yang kita inginkan agar model di training. Iterasi yang selesai itu biasa disebut epochs. Kita ingin menjalankannya selama 100 epochs untuk dapat melihat bagaimana training loss dan accuracy berubah setelah setiap epoch. | |

| − | + | Parameter lain yang kita miliki untuk pilihan adalah ukuran batch (batch size). Ukuran batch bertanggung jawab untuk berapa banyak sampel yang ingin kita gunakan dalam satu epoch, yang berarti berapa banyak sampel yang digunakan dalam satu lintasan maju (forward) / mundur (backward). Ini meningkatkan kecepatan perhitungan karena perlu lebih sedikit epoch untuk run, tetapi juga membutuhkan lebih banyak memori, dan model dapat menurun dengan ukuran batch yang lebih besar. Karena kita memiliki satu set training yang kecil, kita dapat membiarkannya dalam ukuran batch yang rendah: | |

| − | + | history = model.fit(X_train, y_train, | |

| − | + | epochs=100, | |

| − | + | verbose=False, | |

| − | + | validation_data=(X_test, y_test), | |

| − | + | batch_size=10) | |

| − | + | Sekarang kita dapat menggunakan metode .evaluate() untuk mengukur akurasi model. Kita dapat melakukan ini baik untuk data training dan data testing. Kami berharap bahwa data training memiliki akurasi yang lebih tinggi daripada data testing. Semakin lama kita melatih neural network, semakin besar kemungkinan overfitting. | |

| − | + | Perhatikan bahwa jika kita menjalankan kembali metode .fit(), kita akan mulai dengan bobot yang dihitung dari training sebelumnya. Pastikan untuk mengkompilasi model lagi sebelum kita mulai training model itu lagi. Sekarang mari kita evaluasi akurasi model: | |

| − | + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | |

| − | + | print("Training Accuracy: {:.4f}".format(accuracy)) | |

| − | + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | |

| − | + | print("Testing Accuracy: {:.4f}".format(accuracy)) | |

| − | |||

| − | |||

| − | + | Hasilnya | |

| − | + | Training Accuracy: 1.0000 | |

| + | Testing Accuracy: 0.7960 | ||

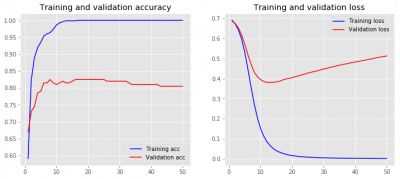

| − | + | Kita sudah dapat melihat bahwa model akan overfitting karena mencapai akurasi 100% untuk set pelatihan. Tapi ini diharapkan karena jumlah epochs yang cukup besar untuk model ini. Namun, keakuratan set testing telah melampaui logistic Regression dengan BOW model, yang merupakan langkah maju yang baik. | |

| − | |||

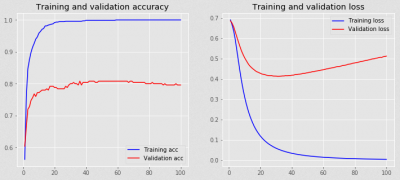

| − | + | Untuk membuat hidup kita lebih mudah, kita dapat menggunakan fungsi helper untuk memvisualisasikan loss dan accuracy untuk training dan testing data berdasarkan history callback. Callback, yang secara otomatis diterapkan pada setiap model Keras, mencatat loss dan metrik tambahan yang dapat ditambahkan dalam metode .fit(). Dalam hal ini, kami hanya tertarik pada accuracy. Fungsi helper ini menggunakan library matplotlib plotting: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | import matplotlib.pyplot as plt | |

| − | + | plt.style.use('ggplot') | |

| − | + | ||

| − | + | def plot_history(history): | |

| − | + | acc = history.history['acc'] | |

| − | + | val_acc = history.history['val_acc'] | |

| − | + | loss = history.history['loss'] | |

| − | + | val_loss = history.history['val_loss'] | |

| − | + | x = range(1, len(acc) + 1) | |

| − | + | ||

| − | + | plt.figure(figsize=(12, 5)) | |

| + | plt.subplot(1, 2, 1) | ||

| + | plt.plot(x, acc, 'b', label='Training acc') | ||

| + | plt.plot(x, val_acc, 'r', label='Validation acc') | ||

| + | plt.title('Training and validation accuracy') | ||

| + | plt.legend() | ||

| + | plt.subplot(1, 2, 2) | ||

| + | plt.plot(x, loss, 'b', label='Training loss') | ||

| + | plt.plot(x, val_loss, 'r', label='Validation loss') | ||

| + | plt.title('Training and validation loss') | ||

| + | plt.legend() | ||

| − | + | Untuk menggunakan fungsi ini, cukup call plot_history() dengan accuracy dan loss yang terkumpul di dalam history dictionary: | |

| − | + | plot_history(history) | |

| − | |||

| − | |||

| − | + | [[File:Loss-accuracy-history.png|center|400px|tumb]] | |

| − | + | Kita dapat melihat bahwa kita telah melatih model terlalu lama sehingga set training mencapai akurasi 100%. Cara yang baik untuk melihat kapan model mulai overfitting adalah ketika loss dari validasi data mulai naik lagi. Ini cenderung menjadi titik yang baik untuk menghentikan model. Anda dapat melihat ini sekitar 20-40 epochs dalam training ini. | |

| − | + | Catatan: Saat melatih neural network, kita harus menggunakan set testing dan validasi yang terpisah. Apa yang biasanya kita lakukan adalah mengambil model dengan akurasi validasi tertinggi dan kemudian menguji model dengan set testing. | |

| − | + | Ini memastikan bahwa kita tidak overfit dari model. Menggunakan set validasi untuk memilih model terbaik adalah bentuk kebocoran data (atau "cheating") untuk memilih hasil yang menghasilkan skor tes terbaik dari ratusan di antaranya. Kebocoran data terjadi ketika informasi di luar set data training digunakan dalam model. | |

| − | |||

| − | + | Dalam hal ini, set testing dan validasi kita adalah sama, karena kita memiliki ukuran sampel yang lebih kecil. Seperti yang telah kita bahas sebelumnya, (deep) neural network berkinerja terbaik ketika kita memiliki jumlah sampel yang sangat besar. Di bagian selanjutnya, kita akan melihat cara berbeda untuk mewakili kata sebagai vektor. Ini adalah cara yang sangat menarik dan kuat untuk bekerja dengan kata-kata di mana kita akan melihat bagaimana merepresentasikan kata-kata sebagai dense vector. | |

| − | + | ==Apakah Word Embedding?== | |

| − | |||

| − | |||

| − | + | Teks dianggap sebagai bentuk urutan data yang mirip dengan data time series yang kita miliki dalam data cuaca atau data keuangan. Dalam model BOW sebelumnya, kita telah melihat cara merepresentasikan seluruh rangkaian kata sebagai vektor fitur tunggal. Sekarang kita akan melihat bagaimana merepresentasikan setiap kata sebagai vektor. Ada berbagai cara untuk membuat vektor teks, seperti: | |

| − | |||

| − | + | * Kata-kata diwakili oleh setiap kata sebagai vektor | |

| + | * Karakter diwakili oleh setiap karakter sebagai vektor | ||

| + | * N-grams dari words/characters diwakili oleh sebuah vector (N-gram adalah kelompok yang saling tumpang tindih dari beberapa kata / karakter berikutnya dalam teks) | ||

| − | + | Dalam tutorial ini, kita akan melihat bagaimana berurusan dengan mewakili kata sebagai vektor yang merupakan cara umum untuk menggunakan teks dalam neural network. Dua cara yang mungkin untuk merepresentasikan sebuah kata sebagai vektor adalah one-hot encoding dan word embedding. | |

| − | + | ==One-Hot Encoding== | |

| − | + | Cara pertama untuk merepresentasikan sebuah kata sebagai vektor adalah dengan menciptakan apa yang disebut one-hot encoding, yang hanya dilakukan dengan mengambil vektor dari panjang vocabulary dengan entri untuk setiap kata dalam korpus. | |

| − | |||

| − | |||

| − | + | Dengan cara ini, untuk setiap kata, kita akan memiliki spot di vocabulary, sebuah vector dengan nilai zero dimana-mana kecuali di spot dari kata tersebut yang di set dengan satu. Seperti yang kita bayangkan, ini bisa menjadi vektor yang cukup besar untuk setiap kata dan tidak memberikan informasi tambahan seperti hubungan antar kata. | |

| − | + | Katakanlah kita memiliki daftar kota seperti dalam contoh berikut: | |

| − | + | cities = ['London', 'Berlin', 'Berlin', 'New York', 'London'] | |

| − | + | cities | |

| − | |||

| − | |||

| − | + | Hasilnya: | |

| − | + | ['London', 'Berlin', 'Berlin', 'New York', 'London'] | |

| − | + | Kita dapat menggunakan scikit-learn dan LabelEncoder untuk meng-encode daftar cities menjadi nilai integer categorical integer sebagai berikut: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | from sklearn.preprocessing import LabelEncoder | |

| − | + | ||

| + | encoder = LabelEncoder() | ||

| + | city_labels = encoder.fit_transform(cities) | ||

| + | city_labels | ||

| − | + | Hasilnya | |

| − | + | array([1, 0, 0, 2, 1]) | |

| − | + | Dengan menggunakan representasi ini, kita dapat menggunakan OneHotEncoder yang disediakan oleh scikit-learn untuk mengkodekan nilai categorical yang kita dapatkan sebelumnya ke dalam one-hot encoded numeric array. OneHotEncoder mengharapkan setiap nilai kategorikal berada di baris terpisah, jadi kita harus reshape array, kemudian kita dapat menerapkan encoder: | |

| − | + | from sklearn.preprocessing import OneHotEncoder | |

| + | |||

| + | encoder = OneHotEncoder(sparse=False) | ||

| + | city_labels = city_labels.reshape((5, 1)) | ||

| + | encoder.fit_transform(city_labels) | ||

| − | + | Hasilnya | |

| − | + | array([[0., 1., 0.], | |

| + | [1., 0., 0.], | ||

| + | [1., 0., 0.], | ||

| + | [0., 0., 1.], | ||

| + | [0., 1., 0.]]) | ||

| − | + | Kita dapat melihat bahwa categorical integer value mewakili posisi array yaitu 1 dan sisanya 0. Ini sering digunakan ketika kita memiliki categorical feature yang tidak dapat kita wakili sebagai nilai numerik tetapi kita masih ingin dapat menggunakannya dalam machine learning. Satu kasus penggunaan untuk pengkodean ini tentu saja kata-kata dalam teks tetapi paling jelas digunakan untuk kategori. Kategori tersebut dapat berupa kota, departemen, atau kategori lainnya. | |

| − | + | ==Word Embeddings== | |

| − | |||

| − | + | Metode ini mewakili kata-kata sebagai vektor kata yang padat (juga disebut word embeddings) yang di-train tidak seperti one-hot encoding. Ini berarti bahwa word embeddings mengumpulkan lebih banyak informasi ke dimensi yang lebih kecil. | |

| − | |||

| − | + | Perhatikan bahwa word embeddings tidak memahami teks seperti yang dilakukan manusia, tetapi mereka lebih memetakan struktur statistik dari bahasa yang digunakan dalam corpus. Tujuan mereka adalah memetakan makna semantik ke dalam ruang geometris. Ruang geometris ini kemudian disebut ruang embedding. | |

| − | + | Ini akan memetakan kata-kata yang mirip secara semantik yang menutup pada ruang embedding seperti angka atau warna. Jika embedding menangkap hubungan antara kata-kata dengan baik, hal-hal seperti vektor aritmatika harusnya dimungkinkan. Contoh terkenal dalam bidang studi ini adalah kemampuan untuk memetakan King - Man + Woman = Queen. | |

| − | |||

| − | |||

| − | |||

| − | + | Bagaimana kita bisa mendapatkan word embedding seperti itu? Kita memiliki dua opsi untuk ini. Salah satu caranya adalah melatih word embeddings anda selama men-training neural network anda. Cara lain adalah dengan menggunakan word embeddings pretrained yang dapat anda langsung gunakan dalam model anda. Di sana anda memiliki opsi untuk membiarkan word embedding ini tidak berubah selama pelatihan atau anda melatihnya juga. | |

| − | + | Sekarang kita perlu melakukan tokenize data menjadi format yang dapat digunakan oleh word embeddings. Keras menawarkan beberapa metode untuk kenyamanan preprocessing teks dan preprocessing urutan yang dapat kita terapkan untuk mempersiapkan teks. | |

| − | + | Kita dapat mulai dengan menggunakan class utlity Tokenizer yang dapat membuat vektor dari corpus teks menjadi daftar bilangan integer. Setiap integer memetakan suatu nilai dalam dictionary yang meng-encode seluruh korpus, dengan kunci dalam dictionary menjadi istilah dalam vocabulary itu sendiri. Kita dapat menambahkan parameter num_words, yang bertanggung jawab untuk mengatur ukuran vocabulary. Kata-kata num_words paling umum akan disimpan. Kita telah memiliki data pengujian dan pelatihan yang disiapkan dari contoh sebelumnya: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | from keras.preprocessing.text import Tokenizer | |

| + | |||

| + | tokenizer = Tokenizer(num_words=5000) | ||

| + | tokenizer.fit_on_texts(sentences_train) | ||

| + | |||

| + | X_train = tokenizer.texts_to_sequences(sentences_train) | ||

| + | X_test = tokenizer.texts_to_sequences(sentences_test) | ||

| + | |||

| + | vocab_size = len(tokenizer.word_index) + 1 # Adding 1 because of reserved 0 index | ||

| + | |||

| + | print(sentences_train[2]) | ||

| + | print(X_train[2]) | ||

| − | + | Hasilnya | |

| − | + | Of all the dishes, the salmon was the best, but all were great. | |

| + | [11, 43, 1, 171, 1, 283, 3, 1, 47, 26, 43, 24, 22] | ||

| − | + | Pengindeksan diurutkan sesuai dengan kata-kata yang paling umum dalam teks, yang dapat kita lihat dengan kata memiliki indeks 1. Penting untuk dicatat bahwa indeks 0 dicadangkan dan tidak diberikan untuk kata apa pun. Indeks nol ini digunakan untuk padding, yang akan diperkenalkan sebentar lagi. | |

| − | + | Kata-kata yang tidak dikenal (kata-kata yang tidak ada dalam vocabulary) dilambangkan dalam Keras dengan word_count +1 karena mereka juga dapat menyimpan beberapa informasi. Kita dapat melihat indeks setiap kata dengan melihat kamus word_index dari objek Tokenizer: | |

| − | + | for word in ['the', 'all', 'happy', 'sad']: | |

| + | print('{}: {}'.format(word, tokenizer.word_index[word])) | ||

| − | + | Hasilnya | |

| − | |||

| − | + | the: 1 | |

| − | + | all: 43 | |

| − | + | happy: 320 | |

| − | + | sad: 450 | |

| − | |||

| − | |||

| − | |||

| − | + | Catatan: Perhatikan perbedaan antara teknik ini dan X_train yang diproduksi oleh CountVectorizer scikit-learn. | |

| − | |||

| − | + | Dengan CountVectorizer, kami telah menumpuk vektor jumlah kata, dan masing-masing vektor memiliki panjang yang sama (ukuran total corpus vocabulary). Dengan Tokenizer, vektor yang dihasilkan sama dengan panjang setiap teks, dan angka tidak menunjukkan jumlah, tetapi lebih sesuai dengan nilai kata dari dictionary tokenizer.word_index. | |

| − | + | Satu masalah yang kita miliki adalah bahwa setiap urutan teks memiliki panjang kata yang berbeda. Untuk mengatasinya, Anda dapat menggunakan pad_afterence() yang akan mengisi urutan kata dengan nol. Secara default, ini akan prepend nol tetapi kami ingin append nol. Biasanya tidak masalah apakah kita akan me-prepend atau append nol. | |

| − | |||

| − | |||

| − | + | Selain itu kita ingin menambahkan parameter maxlen untuk menentukan berapa lama urutannya. Ini memotong urutan yang melebihi angka itu. Dalam kode berikut, kita dapat melihat cara menambahkan urutan dengan Keras: | |

| − | from keras. | + | from keras.preprocessing.sequence import pad_sequences |

| − | + | ||

| + | maxlen = 100 | ||

| + | |||

| + | X_train = pad_sequences(X_train, padding='post', maxlen=maxlen) | ||

| + | X_test = pad_sequences(X_test, padding='post', maxlen=maxlen) | ||

| + | |||

| + | print(X_train[0, :]) | ||

| − | + | Hasilnya | |

| − | + | [ 1 10 3 282 739 25 8 208 30 64 459 230 13 1 124 5 231 8 | |

| − | + | 58 5 67 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 | |

| − | + | 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 | |

| − | + | 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 | |

| − | + | 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 0 | |

| − | + | 0 0 0 0 0 0 0 0 0 0] | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Nilai pertama merepresentasikan indeks dalam vocabulary seperti yang telah kita pelajari dari contoh sebelumnya. Kita juga dapat melihat bahwa feature vector yang dihasilkan sebagian besar berisi nol, karena kita memiliki kalimat yang cukup pendek. Di bagian selanjutnya kita akan melihat cara bekerja dengan word embeddings di Keras. | |

| − | + | ==Keras Embedding Layer== | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Perhatikan bahwa, pada titik ini, data kita masih di encode secara hardcoded. Kita belum memberi tahu Keras untuk mempelajari ruang embedding baru melalui tugas yang berurutan. Sekarang kita dapat menggunakan Layer Embedding Keras yang mengambil bilangan integer yang dihitung sebelumnya dan memetakannya ke dense vector dari embedding. Kita membutuhkan parameter berikut: | |

| − | + | input_dim: ukuran vocabulary | |

| − | + | output_dim: ukuran dense vector | |

| − | + | input_length: panjang sequence / urutan | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Dengan layer Embedding sekarang kita memiliki beberapa opsi. Salah satu caranya adalah dengan mengambil output dari lapisan embedding dan memasukannya ke Dense layer. Untuk melakukan ini, kita harus menambahkan Flatten layer di antaranya yang menyiapkan sequential input untuk Dense layer: | |

| − | + | from keras.models import Sequential | |

| − | + | from keras import layers | |

| + | |||

| + | embedding_dim = 50 | ||

| + | |||

| + | model = Sequential() | ||

| + | model.add(layers.Embedding(input_dim=vocab_size, | ||

| + | output_dim=embedding_dim, | ||

| + | input_length=maxlen)) | ||

| + | model.add(layers.Flatten()) | ||

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| − | + | The result will be as follows: | |

| − | |||

| − | + | _________________________________________________________________ | |

| + | Layer (type) Output Shape Param # | ||

| + | ================================================================= | ||

| + | embedding_8 (Embedding) (None, 100, 50) 87350 | ||

| + | _________________________________________________________________ | ||

| + | flatten_3 (Flatten) (None, 5000) 0 | ||

| + | _________________________________________________________________ | ||

| + | dense_13 (Dense) (None, 10) 50010 | ||

| + | _________________________________________________________________ | ||

| + | dense_14 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 137,371 | ||

| + | Trainable params: 137,371 | ||

| + | Non-trainable params: 0 | ||

| + | _________________________________________________________________ | ||

| − | + | Kita sekarang dapat melihat bahwa kita memiliki 87350 parameter baru untuk di-training. Angka ini berasal dari vocab_size di kali dengan embedding_dim. Weight di lapisan embedding ini di inisialisasi dengan Weight acak dan kemudian disesuaikan melalui backpropagation selama pelatihan. Model ini mengambil kata-kata ketika datang dalam urutan kalimat sebagai vektor input. Kita dapat melatihnya sebagai berikut: | |

| − | + | history = model.fit(X_train, y_train, | |

| + | epochs=20, | ||

| + | verbose=False, | ||

| + | validation_data=(X_test, y_test), | ||

| + | batch_size=10) | ||

| + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | ||

| + | print("Training Accuracy: {:.4f}".format(accuracy)) | ||

| + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | ||

| + | print("Testing Accuracy: {:.4f}".format(accuracy)) | ||

| + | plot_history(history) | ||

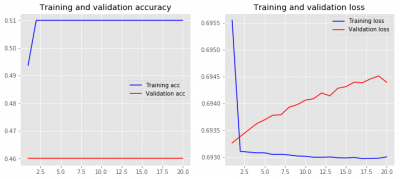

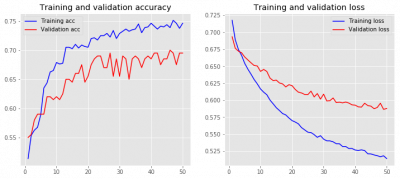

| − | + | Hasilnya | |

| − | + | Training Accuracy: 0.5100 | |

| − | + | Testing Accuracy: 0.4600 | |

| − | |||

| − | + | [[File:Loss-accuracy-first-model.png|center|400px|tumb]] | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | model. | ||

| − | + | Ini biasanya bukan cara yang sangat andal untuk bekerja dengan data berurutan seperti yang kita lihat dalam kinerja. Saat bekerja dengan data sekuensial, kita ingin fokus pada metode yang melihat informasi lokal dan berurutan daripada informasi posisi absolut. | |

| − | + | Cara lain untuk bekerja dengan embeddings adalah dengan menggunakan lapisan MaxPooling1D/AveragePooling1D atau GlobalMaxPooling1D/GlobalAveragePooling1D setelah embedding. Kita dapat menganggap layer pooling sebagai cara untuk menurunkan sampel (cara untuk mengurangi ukuran) feature vector yang masuk. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Dalam hal pooling max, kita mengambil nilai maksimum semua fitur di pooling untuk setiap dimensi feature. Dalam hal average pooling kita mengambil rata-rata, tetapi max pooling tampaknya lebih umum digunakan karena menyoroti nilai-nilai besar. | |

| − | + | Global max/average pooling mengambil maximum/average dari semua feature sementara dalam kasus lainnya kita harus menentukan pool size. Keras sudah memiliki lapisannya sendiri yang dapat kita tambahkan dalam model sekuensial: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | from keras.models import Sequential | |

| + | from keras import layers | ||

| + | |||

| + | embedding_dim = 50 | ||

| + | |||

| + | model = Sequential() | ||

| + | model.add(layers.Embedding(input_dim=vocab_size, | ||

| + | output_dim=embedding_dim, | ||

| + | input_length=maxlen)) | ||

| + | model.add(layers.GlobalMaxPool1D()) | ||

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| − | + | Hasilnya: | |

| − | |||

| − | + | _________________________________________________________________ | |

| − | + | Layer (type) Output Shape Param # | |

| + | ================================================================= | ||

| + | embedding_9 (Embedding) (None, 100, 50) 87350 | ||

| + | _________________________________________________________________ | ||

| + | global_max_pooling1d_5 (Glob (None, 50) 0 | ||

| + | _________________________________________________________________ | ||

| + | dense_15 (Dense) (None, 10) 510 | ||

| + | _________________________________________________________________ | ||

| + | dense_16 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 87,871 | ||

| + | Trainable params: 87,871 | ||

| + | Non-trainable params: 0 | ||

| + | _________________________________________________________________ | ||

| − | + | Prosedur untuk training tidak berubah: | |

| − | |||

| − | + | history = model.fit(X_train, y_train, | |

| + | epochs=50, | ||

| + | verbose=False, | ||

| + | validation_data=(X_test, y_test), | ||

| + | batch_size=10) | ||

| + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | ||

| + | print("Training Accuracy: {:.4f}".format(accuracy)) | ||

| + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | ||

| + | print("Testing Accuracy: {:.4f}".format(accuracy)) | ||

| + | plot_history(history) | ||

| + | |||

| + | Hasil | ||

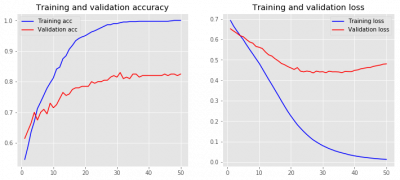

| − | + | Training Accuracy: 1.0000 | |

| + | Testing Accuracy: 0.8050 | ||

| − | + | [[File:Loss-accurcay-max-pooling2.png|center|400px|thumb]] | |

| − | + | Kita sudah dapat melihat beberapa peningkatan dalam model kita. Selanjutnya kita akan melihat bagaimana kita dapat menggunakan pretrained word embeddings dan jika hal tersebut bisa membantu kita dengan model yang kita gunakan. | |

| − | + | ==Penggunaan Pretrained Word Embeddings== | |

| − | + | Kita baru saja melihat contoh belajar word embeddings yang dimasukkan ke dalam model yang lebih besar yang ingin kita pecahkan. | |

| − | + | Alternatif lain adalah dengan menggunakan ruang embedding yang dikomputasi yang menggunakan corpus yang jauh lebih besar. Dimungkinkan untuk memulai word embedding dengan hanya melatihnya pada kumpulan teks yang besar. Di antara metode yang paling populer adalah Word2Vec yang dikembangkan oleh Google dan GloVe (Global Vectors for Word Representation) yang dikembangkan oleh Stanford NLP Group. | |

| − | + | Perhatikan bahwa itu adalah pendekatan yang berbeda dengan tujuan yang sama. Word2Vec mencapai ini dengan menggunakan neural networks dan GloVe mencapainya dengan co-occurrence matrix bersama dan dengan menggunakan faktorisasi matriks. Dalam kedua kasus kita akan berurusan dengan pengurangan dimensionalitas, tetapi Word2Vec lebih akurat dan GloVe lebih cepat untuk dihitung. | |

| − | |||

| − | + | Dalam tutorial ini, kita akan melihat cara bekerja dengan word embeddings GloVe dan bukan Stanford NLP Group karena ukurannya lebih mudah dikelola daripada embeddings Word2Vec yang disediakan oleh Google. Silakan dan unduh word embeddings 6B (terlatih 6 miliar kata) dari http://nlp.stanford.edu/data/glove.6B.zip (822 MB). | |

| − | + | Kita dapat menemukan word embeddings lainnya juga di halaman utama GloVe https://nlp.stanford.edu/projects/glove/. Kita dapat menemukan pretrained Word2Vec embeddings oleh Google di https://code.google.com/archive/p/word2vec/ . Jika anda ingin melatih word embeddings anda sendiri, anda dapat melakukannya secara efisien dengan paket gensim Python https://radimrehurek.com/gensim/index.html yang menggunakan Word2Vec untuk perhitungan. Rincian lebih lanjut tentang cara melakukan ini di https://radimrehurek.com/gensim/models/word2vec.html . | |

| − | + | Kita dapat mulai menggunakan word embeddings dalam model kita. Kita dapat melihat pada contoh berikut bagaimana kita dapat memuat embedding matrix. Setiap baris dalam file dimulai dengan kata dan diikuti oleh embedding vector untuk kata tertentu. | |

| − | |||

| − | |||

| − | + | Ini adalah file besar dengan 400.000 baris, dengan setiap baris mewakili kata yang diikuti oleh vektornya sebagai aliran floating point. Misalnya, berikut adalah 50 karakter pertama dari baris pertama: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | $ head -n 1 glove.6B/glove.6B.50d.txt | cut -c-50 | |

| + | the 0.418 0.24968 -0.41242 0.1217 0.34527 -0.04445 | ||

| − | + | Karena kita tidak membutuhkan semua kata, kita hanya dapat fokus pada kata-kata yang kita miliki dalam vocabulary kita. Karena kita hanya memiliki jumlah kata yang terbatas dalam vocabulary kita, kita dapat melewatkan sebagian besar dari 40000 kata dalam pretrained word embeddings: | |

| − | + | import numpy as np | |

| − | + | ||

| − | .. | + | def create_embedding_matrix(filepath, word_index, embedding_dim): |

| − | . | + | vocab_size = len(word_index) + 1 # Adding again 1 because of reserved 0 index |

| + | embedding_matrix = np.zeros((vocab_size, embedding_dim)) | ||

| + | |||

| + | with open(filepath) as f: | ||

| + | for line in f: | ||

| + | word, *vector = line.split() | ||

| + | if word in word_index: | ||

| + | idx = word_index[word] | ||

| + | embedding_matrix[idx] = np.array( | ||

| + | vector, dtype=np.float32)[:embedding_dim] | ||

| + | return embedding_matrix | ||

| − | + | Kita dapat menggunakan fungsi ini sekarang untuk mengambil embedding matrix: | |

| − | + | embedding_dim = 50 | |

| + | embedding_matrix = create_embedding_matrix( | ||

| + | '/home/onno/TensorFlow/glove.6B/glove.6B.50d.txt', | ||

| + | tokenizer.word_index, embedding_dim) | ||

| − | + | Sekarang kita siap menggunakan embedding matrix dalam training. Mari gunakan network sebelumnya dengan global max pooling dan lihat apakah kita bisa meningkatkan model ini. Saat kita menggunakan pretrained word embeddings kita memiliki pilihan untuk memperbolehkan embedding diperbarui selama training atau hanya menggunakan embedding vectors yang dihasilkan apa adanya. | |

| − | |||

| − | |||

| − | + | Pertama, mari kita lihat sekilas berapa banyak embedding vectors yang bukan nol: | |

| − | + | nonzero_elements = np.count_nonzero(np.count_nonzero(embedding_matrix, axis=1)) | |

| − | + | print(nonzero_elements / vocab_size) | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Hasilnya: | |

| − | + | 0.9522330097087378 | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Ini berarti 95.1% dari vocabulary tercakup oleh pretrained model, yang merupakan cakupan yang baik dari vocabulary kita. Mari kita lihat kinerja ketika menggunakan lapisan GlobalMaxPool1D: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | model = Sequential() | |

| + | model.add(layers.Embedding(vocab_size, embedding_dim, | ||

| + | weights=[embedding_matrix], | ||

| + | input_length=maxlen, | ||

| + | trainable=False)) | ||

| + | model.add(layers.GlobalMaxPool1D()) | ||

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| − | + | Hasilnya: | |

| − | |||

| − | + | _________________________________________________________________ | |

| − | + | Layer (type) Output Shape Param # | |

| + | ================================================================= | ||

| + | embedding_10 (Embedding) (None, 100, 50) 87350 | ||

| + | _________________________________________________________________ | ||

| + | global_max_pooling1d_6 (Glob (None, 50) 0 | ||

| + | _________________________________________________________________ | ||

| + | dense_17 (Dense) (None, 10) 510 | ||

| + | _________________________________________________________________ | ||

| + | dense_18 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 87,871 | ||

| + | Trainable params: 521 | ||

| + | Non-trainable params: 87,350 | ||

| + | _________________________________________________________________ | ||

| − | + | history = model.fit(X_train, y_train, | |

| + | epochs=50, | ||

| + | verbose=False, | ||

| + | validation_data=(X_test, y_test), | ||

| + | batch_size=10) | ||

| + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | ||

| + | print("Training Accuracy: {:.4f}".format(accuracy)) | ||

| + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | ||

| + | print("Testing Accuracy: {:.4f}".format(accuracy)) | ||

| + | plot_history(history) | ||

| − | + | Hasilnya: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Training Accuracy: 0.7500 | |

| + | Testing Accuracy: 0.6950 | ||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | [[File:Loss-accuracy-embedding-untrained.png|center|400px|thumb]] | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Karena word embeddings tidak memperoleh training tambahan, maka hasilnya akan lebih rendah. Tetapi sekarang mari kita lihat bagaimana kinerjanya jika kita mengizinkan embedding untuk di training dengan menggunakan trainable=True: | |

| − | + | model = Sequential() | |

| − | + | model.add(layers.Embedding(vocab_size, embedding_dim, | |

| + | weights=[embedding_matrix], | ||

| + | input_length=maxlen, | ||

| + | trainable=True)) | ||

| + | model.add(layers.GlobalMaxPool1D()) | ||

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| − | + | Hasilnya: | |

| − | |||

| − | + | _________________________________________________________________ | |

| + | Layer (type) Output Shape Param # | ||

| + | ================================================================= | ||

| + | embedding_11 (Embedding) (None, 100, 50) 87350 | ||

| + | _________________________________________________________________ | ||

| + | global_max_pooling1d_7 (Glob (None, 50) 0 | ||

| + | _________________________________________________________________ | ||

| + | dense_19 (Dense) (None, 10) 510 | ||

| + | _________________________________________________________________ | ||

| + | dense_20 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 87,871 | ||

| + | Trainable params: 87,871 | ||

| + | Non-trainable params: 0 | ||

| + | _________________________________________________________________ | ||

| − | + | history = model.fit(X_train, y_train, | |

| − | + | epochs=50, | |

| + | verbose=False, | ||

| + | validation_data=(X_test, y_test), | ||

| + | batch_size=10) | ||

| + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | ||

| + | print("Training Accuracy: {:.4f}".format(accuracy)) | ||

| + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | ||

| + | print("Testing Accuracy: {:.4f}".format(accuracy)) | ||

| + | plot_history(history) | ||

| − | + | Hasilnya: | |

| − | + | Training Accuracy: 1.0000 | |

| + | Testing Accuracy: 0.8250 | ||

| − | + | [[File:Loss-accuracy-embedding-trained.png|center|400px|thub]] | |

| − | + | Kita dapat lihat bahwa paling efektif jika mengijinkan embeddings di train. Ketika berhadapan dengan set training yang besar, itu dapat meningkatkan proses training menjadi lebih cepat daripada tanpa. Dalam kasus kita, itu tampaknya membantu tetapi tidak banyak. Ini tidak harus karena pretrained word embeddings. | |

| − | + | Sekarang saatnya untuk fokus pada model neural network yang lebih maju untuk melihat apakah mungkin untuk meningkatkan model dan memberikan keunggulan pada model-model sebelumnya. | |

| − | + | ==Convolutional Neural Networks (CNN)== | |

| − | + | Convolutional neural networks atau disebut juga convnets adalah salah satu perkembangan paling menarik dalam machine learning dalam beberapa tahun terakhir. | |

| − | |||

| − | |||

| − | + | Mereka telah merevolusi klasifikasi gambar dan computer vision dengan mampu mengekstraksi fitur dari gambar dan menggunakannya dalam neural networks. Properti yang membuatnya berguna dalam pemrosesan gambar membuat mereka juga berguna untuk pemrosesan urutan. Anda dapat membayangkan CNN sebagai specialized neural network yang mampu mendeteksi pola tertentu. | |

| − | + | Jika itu hanya neural network lain, apa yang membedakannya dari apa yang telah kita pelajari sebelumnya? | |

| − | + | CNN memiliki lapisan tersembunyi yang disebut lapisan konvolusional. Ketika kita membayangkan sebuah gambar, komputer harus berurusan dengan matrix dua dimensi angka dan oleh karena itu kita perlu beberapa cara untuk mendeteksi fitur dalam matrix ini. Lapisan konvolusional ini mampu mendeteksi tepi, sudut dan jenis tekstur lainnya yang menjadikannya tool yang istimewa. Lapisan convolutional terdiri dari beberapa filter yang digeser melintasi gambar dan dapat mendeteksi fitur-fitur tertentu. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Ini adalah inti dari tekniknya, proses konvolusi matematika. Dengan setiap lapisan konvolusional, network dapat mendeteksi pola yang lebih kompleks. Dalam Feature Visualization https://distill.pub/2017/feature-visualization/ oleh Chris Olah kita bisa mendapatkan intuisi yang baik seperti apa fitur-fitur ini. | |

| − | + | Saat kita bekerja dengan data sekuensial, seperti teks, kita bekerja dengan konvolusi satu dimensi, tetapi gagasan dan aplikasinya tetap sama. Kita masih ingin menangkap pola dalam urutan yang menjadi lebih kompleks dengan setiap lapisan konvolusional yang ditambahkan. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

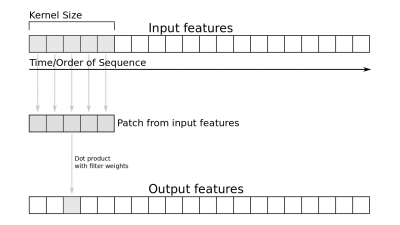

| − | + | Pada gambar berikut, kita dapat melihat bagaimana konvolusi bekerja. Dimulai dengan menambahkan patch fitur input dengan ukuran kernel filter. Dengan patch ini, kita mengambil produk dot dari Weight filter yang dikalikan. Convnet satu dimensi tidak sama dengan terjemahan, yang berarti bahwa urutan tertentu dapat dikenali pada posisi yang berbeda. Ini dapat membantu untuk pola-pola tertentu dalam teks: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | [[File:1d-convolution.png|center|400px|thumb]] | |

| − | + | ==1D Convolution (Image source)== | |

| − | |||

| − | + | Sekarang mari kita lihat bagaimana kita dapat menggunakan network ini di Keras. Keras menawarkan lagi berbagai lapisan konvolusional yang dapat kita gunakan untuk tugas ini. Lapisan yang kita butuhkan adalah lapisan Conv1D. Lapisan ini memiliki lagi berbagai parameter untuk dipilih. Yang kita minati saat ini adalah jumlah filter, ukuran kernel, dan fungsi aktivasi. Kita bisa menambahkan lapisan ini di antara lapisan Embedding dan lapisan GlobalMaxPool1D: | |

| − | |||

| − | + | embedding_dim = 100 | |

| + | |||

| + | model = Sequential() | ||

| + | model.add(layers.Embedding(vocab_size, embedding_dim, input_length=maxlen)) | ||

| + | model.add(layers.Conv1D(128, 5, activation='relu')) | ||

| + | model.add(layers.GlobalMaxPooling1D()) | ||

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | model.summary() | ||

| − | + | Hasilnya: | |

| − | |||

| − | |||

| − | + | _________________________________________________________________ | |

| − | + | Layer (type) Output Shape Param # | |

| + | ================================================================= | ||

| + | embedding_13 (Embedding) (None, 100, 100) 174700 | ||

| + | _________________________________________________________________ | ||

| + | conv1d_2 (Conv1D) (None, 96, 128) 64128 | ||

| + | _________________________________________________________________ | ||

| + | global_max_pooling1d_9 (Glob (None, 128) 0 | ||

| + | _________________________________________________________________ | ||

| + | dense_23 (Dense) (None, 10) 1290 | ||

| + | _________________________________________________________________ | ||

| + | dense_24 (Dense) (None, 1) 11 | ||

| + | ================================================================= | ||

| + | Total params: 240,129 | ||

| + | Trainable params: 240,129 | ||

| + | Non-trainable params: 0 | ||

| + | _________________________________________________________________ | ||

| − | + | history = model.fit(X_train, y_train, | |

| + | epochs=10, | ||

| + | verbose=False, | ||

| + | validation_data=(X_test, y_test), | ||

| + | batch_size=10) | ||

| + | loss, accuracy = model.evaluate(X_train, y_train, verbose=False) | ||

| + | print("Training Accuracy: {:.4f}".format(accuracy)) | ||

| + | loss, accuracy = model.evaluate(X_test, y_test, verbose=False) | ||

| + | print("Testing Accuracy: {:.4f}".format(accuracy)) | ||

| + | plot_history(history) | ||

| − | + | Hasilnya: | |

| − | + | Training Accuracy: 1.0000 | |

| + | Testing Accuracy: 0.7700 | ||

| − | + | [[File:Loss-accuracy-convolution-model4.png|center|400px|thumb]] | |

| − | + | Anda dapat melihat bahwa accuracy 80% tampaknya merupakan rintangan yang sulit untuk diatasi dengan kumpulan data ini dan CNN mungkin tidak dilengkapi dengan baik. Alasan untuk dataran tinggi accuracy seperti itu adalah: | |

| − | + | * Tidak cukup banyak sample training | |

| + | * Data yang kita miliki kurang generalize | ||

| + | * Gagal fokus saat mengatur hyperparameters | ||

| − | + | CNN bekerja paling baik dengan training set yang besar di mana mereka dapat menemukan generalisasi di mana model sederhana seperti regresi logistik tidak akan mampu. | |

| − | + | ==Optimasi Hyperparameters== | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Salah satu langkah penting dalam deep learnig dan bekerja dengan neural network adalah optimasi hyperparameter. | |

| − | + | Seperti yang kita lihat dalam model yang telah kita gunakan sejauh ini, bahkan dengan model yang lebih sederhana, kita memiliki sejumlah besar parameter untuk di-tweak dan dipilih. Parameter tersebut disebut hyperparameters. Ini adalah bagian yang paling memakan waktu dari machine learning dan sayangnya tidak ada solusi yang cocok untuk semua. | |

| − | + | Ketika anda melihat kompetisi di Kaggle, salah satu tempat terbesar untuk bersaing dengan sesama ilmuwan data lainnya, anda dapat melihat bahwa banyak tim dan model pemenang telah melalui banyak penyesuaian dan percobaan hingga mencapai puncaknya. Jadi jangan berkecil hati ketika menjadi sulit dan anda mencapai dataran tinggi, tetapi pikirkan cara anda dapat mengoptimalkan model atau data. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Salah satu metode populer untuk optimasi hyperparameter adalah grid search. Apa yang dilakukan metode ini adalah mengambil daftar parameter dan menjalankan model dengan setiap kombinasi parameter yang dapat ditemukannya. Ini adalah cara yang paling menyeluruh tetapi juga cara yang paling berat secara komputasi untuk melakukan ini. Cara umum lain, pencarian acak, yang akan kita lihat dalam tindakan di sini, cukup mengambil kombinasi parameter secara acak. | |

| − | + | Untuk menerapkan random search dengan Keras, kita harus menggunakan KerasClassifier yang berfungsi sebagai pembungkus untuk scikit-learn API. Dengan pembungkus ini kita dapat menggunakan berbagai tool yang tersedia dengan scikit-learn seperti cross-validation. Class yang kita butuhkan adalah RandomizedSearchCV yang mengimplementasikan random search dengan cross-validation. Cross-validation adalah cara untuk memvalidasi model dan mengambil seluruh rangkaian data dan memisahkannya menjadi beberapa data set testing dan training. | |

| − | + | Ada berbagai jenis cross-validation. Salah satu jenis adalah cross-validation k-fold yang akan kita lihat dalam contoh ini. Dalam tipe ini set data dipartisi ke dalam k set ukuran yang sama di mana satu set digunakan untuk testing dan sisanya dari partisi digunakan untuk training. Ini memungkinkan kita untuk menjalankan k dalam berbagai proses yang berbeda, di mana setiap partisi pernah digunakan sebagai set testing. Jadi, semakin tinggi k adalah semakin akurat model evaluasi, tetapi semakin kecil setiap set testing-nya. | |

| − | |||

| − | + | Langkah pertama untuk KerasClassifier adalah memiliki fungsi yang menciptakan model Keras. Kita akan menggunakan model sebelumnya, tetapi kita akan mengizinkan berbagai parameter ditetapkan untuk optimasi hyperparameter: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | def create_model(num_filters, kernel_size, vocab_size, embedding_dim, maxlen): | |

| − | + | model = Sequential() | |

| − | + | model.add(layers.Embedding(vocab_size, embedding_dim, input_length=maxlen)) | |

| − | + | model.add(layers.Conv1D(num_filters, kernel_size, activation='relu')) | |

| − | + | model.add(layers.GlobalMaxPooling1D()) | |

| + | model.add(layers.Dense(10, activation='relu')) | ||

| + | model.add(layers.Dense(1, activation='sigmoid')) | ||

| + | model.compile(optimizer='adam', | ||

| + | loss='binary_crossentropy', | ||

| + | metrics=['accuracy']) | ||

| + | return model | ||

| − | + | Selanjutnya, kita ingin menentukan parameter grid yang ingin kita gunakan dalam training. Ini terdiri dari dictionary dengan masing-masing parameter dalam fungsi sebelumnya. Jumlah spasi di grid adalah 3 * 3 * 1 * 1 * 1, di mana masing-masing angka tersebut adalah jumlah pilihan yang berbeda untuk parameter yang diberikan. | |

| − | |||

| − | |||

| − | + | Kita dapat melihat bagaimana ini bisa menjadi komputasi yang mahal dengan sangat cepat, tetapi untungnya grid search dan random search sebetulnya paralel, dan class muncul dengan parameter n_jobs yang memungkinkan kita menguji ruang grid secara paralel. Kotak parameter diinisialisasi dengan dictionary berikut: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | param_grid = dict(num_filters=[32, 64, 128], | |

| − | + | kernel_size=[3, 5, 7], | |

| + | vocab_size=[5000], | ||

| + | embedding_dim=[50], | ||

| + | maxlen=[100]) | ||

| − | + | Sekarang kita sudah siap untuk mulai menjalankan random search. Dalam contoh ini kita mengulang setiap set data dan kemudian kita ingin memproses ulang data dengan cara yang sama seperti sebelumnya. Setelah itu kita mengambil fungsi sebelumnya dan menambahkannya ke KerasClassifier wrapper class termasuk jumlah epoch. | |

| − | + | Instance yang dihasilkan dan parameter grid kemudian digunakan sebagai estimator di RandomSearchCV class. | |

| − | |||

| − | + | Selain itu, kita dapat memilih jumlah fold dalam k-folds cross-validation, yang dalam kasus ini 4. Kita telah melihat sebagian besar kode dalam cuplikan ini sebelumnya dalam contoh sebelumnya. Selain RandomSearchCV dan KerasClassifier, telah menambahkan sedikit kode untuk penanganan evaluasi: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | from keras.wrappers.scikit_learn import KerasClassifier | |

| − | + | from sklearn.model_selection import RandomizedSearchCV | |

| + | |||

| + | # Main settings | ||

| + | epochs = 20 | ||

| + | embedding_dim = 50 | ||

| + | maxlen = 100 | ||

| + | output_file = 'data/output.txt' | ||

| + | |||

| + | # Run grid search for each source (yelp, amazon, imdb) | ||

| + | for source, frame in df.groupby('source'): | ||

| + | print('Running grid search for data set :', source) | ||

| + | sentences = df['sentence'].values | ||

| + | y = df['label'].values | ||

| + | |||

| + | # Train-test split | ||

| + | sentences_train, sentences_test, y_train, y_test = train_test_split( | ||

| + | sentences, y, test_size=0.25, random_state=1000) | ||

| + | |||

| + | # Tokenize words | ||

| + | tokenizer = Tokenizer(num_words=5000) | ||

| + | tokenizer.fit_on_texts(sentences_train) | ||

| + | X_train = tokenizer.texts_to_sequences(sentences_train) | ||

| + | X_test = tokenizer.texts_to_sequences(sentences_test) | ||

| + | |||

| + | # Adding 1 because of reserved 0 index | ||

| + | vocab_size = len(tokenizer.word_index) + 1 | ||

| + | |||

| + | # Pad sequences with zeros | ||

| + | X_train = pad_sequences(X_train, padding='post', maxlen=maxlen) | ||

| + | X_test = pad_sequences(X_test, padding='post', maxlen=maxlen) | ||

| + | |||

| + | # Parameter grid for grid search | ||

| + | param_grid = dict(num_filters=[32, 64, 128], | ||

| + | kernel_size=[3, 5, 7], | ||

| + | vocab_size=[vocab_size], | ||

| + | embedding_dim=[embedding_dim], | ||

| + | maxlen=[maxlen]) | ||

| + | model = KerasClassifier(build_fn=create_model, | ||

| + | epochs=epochs, batch_size=10, | ||

| + | verbose=False) | ||

| + | grid = RandomizedSearchCV(estimator=model, param_distributions=param_grid, | ||

| + | cv=4, verbose=1, n_iter=5) | ||

| + | grid_result = grid.fit(X_train, y_train) | ||

| + | |||

| + | # Evaluate testing set | ||

| + | test_accuracy = grid.score(X_test, y_test) | ||

| + | |||

| + | # Save and evaluate results | ||

| + | prompt = input(f'finished {source}; write to file and proceed? [y/n]') | ||

| + | if prompt.lower() not in {'y', 'true', 'yes'}: | ||

| + | break | ||

| + | with open(output_file, 'a') as f: | ||

| + | s = ('Running {} data set\nBest Accuracy : ' | ||

| + | '{:.4f}\n{}\nTest Accuracy : {:.4f}\n\n') | ||

| + | output_string = s.format( | ||

| + | source, | ||

| + | grid_result.best_score_, | ||

| + | grid_result.best_params_, | ||

| + | test_accuracy) | ||

| + | print(output_string) | ||

| + | f.write(output_string) | ||

| − | + | Ini membutuhkan waktu yang merupakan kesempatan sempurna untuk pergi keluar untuk mendapatkan udara segar atau bahkan mendaki gunung, tergantung pada berapa banyak model yang ingin kita jalankan. Mari kita lihat apa yang kita punya: | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Running amazon data set | |

| + | Best Accuracy : 0.8122 | ||

| + | {'vocab_size': 4603, 'num_filters': 64, 'maxlen': 100, 'kernel_size': 5, 'embedding_dim': 50} | ||

| + | Test Accuracy : 0.8457 | ||

| − | Running | + | Running imdb data set |

| − | Best Accuracy : 0. | + | Best Accuracy : 0.8161 |

| − | {'vocab_size': 4603, 'num_filters': | + | {'vocab_size': 4603, 'num_filters': 128, 'maxlen': 100, 'kernel_size': 5, 'embedding_dim': 50} |

| − | Test Accuracy : 0. | + | Test Accuracy : 0.8210 |

| − | Running | + | Running yelp data set |

| − | Best Accuracy : 0. | + | Best Accuracy : 0.8127 |

| − | {'vocab_size': 4603, 'num_filters': | + | {'vocab_size': 4603, 'num_filters': 64, 'maxlen': 100, 'kernel_size': 7, 'embedding_dim': 50} |

| − | Test Accuracy : 0. | + | Test Accuracy : 0.8384 |

| − | + | Menarik! Untuk beberapa hal maka akurasi testing lebih tinggi daripada akurasi training yang mungkin karena ada perbedaan besar dalam skor selama cross-validation. Kita dapat melihat bahwa kita masih tidak dapat menembus banyak melalui 80% yang ditakuti, yang tampaknya menjadi batas alami untuk data ini dengan ukuran yang diberikan. Ingat bahwa kita memiliki satu set data kecil dan convolutional neural networks cenderung melakukan yang terbaik dengan set data besar. | |

| − | |||

| − | |||

| − | |||

| − | + | Metode lain untuk CV adalah nested cross-validation (ditampilkan di sini) yang digunakan ketika hyperparameters juga perlu dioptimalkan. Ini digunakan karena model non-nested CV yang dihasilkan memiliki bias terhadap kumpulan data yang dapat menyebabkan skor terlalu optimis. Kita tahu, ketika melakukan optimasi hiperparameter seperti yang kita lakukan dalam contoh sebelumnya, kita memilih hyperparameter terbaik untuk set training tertentu tetapi ini tidak berarti bahwa hyperparameter ini menggeneralisasi yang terbaik. | |

| − | + | ==Conclusion== | |

| − | Conclusion | ||

| − | + | Kita telah belajar cara bekerja dengan klasifikasi teks dengan Keras, dan kita telah beralih dari model bag-of-words dengan regresi logistik menjadi metode yang semakin maju yang mengarah ke convolutional neural networks. | |

| − | + | Kita sekarang harus terbiasa dengan word embeddings, mengapa mereka berguna, dan juga bagaimana menggunakan pretrained word embeddings untuk training kita. Kita juga telah belajar cara bekerja dengan neural network dan cara menggunakan optimasi hyperparameter untuk memeras lebih banyak kinerja dari model kita. | |

| − | + | Satu topik besar yang belum kita bahas di sini dibiarkan lain waktu adalah recurrent neural networks, lebih khusus LSTM dan GRU. Itu adalah tool powerfull dan populer lainnya untuk bekerja dengan data sequential seperti teks atau time series. Perkembangan menarik lainnya saat ini dalam neural network yang menggunakan perhatian yang sedang dalam penelitian aktif dan tampaknya menjadi langkah berikutnya yang menjanjikan karena LSTM cenderung berat pada perhitungan. | |

| − | + | Kita sekarang memiliki pemahaman tentang landasan penting dalam natural language processing yang dapat kita gunakan untuk semua jenis text classification. Analisis sentimen adalah contoh yang paling menonjol untuk ini, tetapi ini mencakup banyak aplikasi lain seperti: | |

| − | + | * Deteksi Spam di email | |

| − | + | * Automatic tagging pada text | |

| − | + | * Kategorisasi artikel berita untuk topik yang sudah di definisikan. | |

| − | + | Kita dapat menggunakan pengetahuan ini dan model-model yang telah kita latih pada proyek lanjutan seperti dalam tutorial ini untuk menggunakan analisis sentimen pada continuous stream data twitter dengan Kibana dan Elasticsearch. Kita juga bisa menggabungkan analisis sentimen atau text classification dengan speech recognition seperti dalam tutorial praktis ini menggunakan library SpeechRecognition di Python. | |

==Referensi== | ==Referensi== | ||

| Line 959: | Line 993: | ||

==Pranala Menarik== | ==Pranala Menarik== | ||

| + | |||

| + | * [[Keras]] | ||

Latest revision as of 08:30, 14 August 2019

Sumber: https://realpython.com/python-keras-text-classification/

Bayangkan kita bisa mengetahui mood orang-orang di Internet. Mungkin kita tidak tertarik secara keseluruhan, tetapi cukup happy melihat orang bahagia di platform media sosial favorit kita. Setelah tutorial ini, kita akan diperlengkapi untuk melakukan ini. Saat melakukan ini, kita akan memahami kemajuan di (deep) neural network saat ini dan bagaimana penerapannya pada teks.

Membaca mood dari teks dengan machine learning dikenal dengan analisis sentimen, dan itu adalah salah satu kasus penggunaan yang menonjol dalam klasifikasi teks. Ini masuk ke bidang penelitian yang sangat aktif dari natural language processing (NLP). Kasus penggunaan umum lainnya dari klasifikasi teks termasuk deteksi spam, penandaan otomatis atas permintaan pelanggan, dan kategorisasi teks ke dalam topik yang ditentukan. Jadi, bagaimana kita bisa melakukan ini?

Memilih Dataset

Sebelum kita mulai, mari kita lihat data apa yang kita miliki. Pergi dan unduh kumpulan data dari Sentiment Labelled Sentences Data Set dari UCI Machine Learning Repository https://archive.ics.uci.edu/ml/datasets/Sentiment+Labelled+Sentences

Repositori ini adalah sumber yang bagus untuk data set machine learning jika kita ingin mencoba beberapa algoritma. Kumpulan data ini mencakup review berlabel dari IMDb, Amazon, dan Yelp. Setiap ulasan ditandai dengan skor 0 untuk sentimen negatif atau 1 untuk sentimen positif.

Ekstrak folder ke folder data, lanjut dengan load data dengan Pandas:

import pandas as pd

filepath_dict = {'yelp': '/home/onno/TensorFlow/data/sentiment_analysis/yelp_labelled.txt',

'amazon': '/home/onno/TensorFlow/data/sentiment_analysis/amazon_cells_labelled.txt',

'imdb': '/home/onno/TensorFlow/data/sentiment_analysis/imdb_labelled.txt'}

df_list = []

for source, filepath in filepath_dict.items():

df = pd.read_csv(filepath, names=['sentence', 'label'], sep='\t')

df['source'] = source # Add another column filled with the source name

df_list.append(df)

df = pd.concat(df_list)

print(df.iloc[0])

Hasilnya kira-kira sebagai berikut,

sentence Wow... Loved this place. label 1 source yelp Name: 0, dtype: object

Ini terlihat benar. Dengan kumpulan data ini, kita dapat melatih model untuk memprediksi sentimen dari sebuah kalimat. Luangkan waktu sejenak untuk memikirkan bagaimana kita akan memprediksi data.

Salah satu cara kita dapat melakukan ini adalah dengan menghitung frekuensi setiap kata dalam setiap kalimat dan menghubungkan penghitungan ini kembali ke seluruh rangkaian kata dalam dataset. Kita akan mulai dengan mengambil data dan membuat kosa kata dari semua kata dalam semua kalimat. Kumpulan teks juga disebut corpus di NLP.

Vocabulary dalam hal ini adalah daftar kata-kata yang ada dalam teks di mana setiap kata memiliki indeks sendiri. Ini memungkinkan kita membuat vektor untuk sebuah kalimat. Kita kemudian akan mengambil kalimat yang ingin kita vektorisasi, dan kita menghitung setiap kemunculannya dalam kosa kata. Vektor yang dihasilkan akan dengan panjang kosakata dan jumlah untuk setiap kata dalam vocabulary.

Vektor yang dihasilkan biasa disebut feature vector. Dalam feature vector, setiap dimensi dapat berupa fitur numerik atau kategorikal, seperti misalnya tinggi bangunan, harga saham, atau, dalam kasus ini, hitungan kata dalam vocabulary. Feature Vector ini adalah bagian penting dalam data science dan machine learning, karena model yang ingin kita latih tergantung pada mereka.

Mari kita ilustrasikan ini dengan cepat. Bayangkan kita memiliki dua kalimat berikut:

sentences = ['John likes ice cream', 'John hates chocolate.']

Selanjutnya, kita dapat menggunakan CountVectorizer yang disediakan oleh scikit-learn library untuk membuat vektor kalimat. Library ini akan mengambil kata-kata dari setiap kalimat dan menciptakan vocabulary dari semua kata unik dalam kalimat. Vocabulary ini kemudian dapat digunakan untuk membuat feature vector dari jumlah kata:

from sklearn.feature_extraction.text import CountVectorizer

vectorizer = CountVectorizer(min_df=0, lowercase=False) vectorizer.fit(sentences) vectorizer.vocabulary_

Hasilnya:

{'John': 0, 'chocolate': 1, 'cream': 2, 'hates': 3, 'ice': 4, 'likes': 5}

Vocabulary ini juga berfungsi sebagai indeks setiap kata. Sekarang, kita dapat mengambil setiap kalimat dan mendapatkan kemunculan kata berdasarkan vocabulary sebelumnya. Vocabulary terdiri dari semua lima kata dalam kalimat ini, masing-masing mewakili satu kata dalam Vocabulary. Ketika kita mengambil dua kalimat sebelumnya dan mengubahnya dengan CountVectorizer maka kita akan mendapatkan vektor yang mewakili jumlah setiap kata dari kalimat:

vectorizer.transform(sentences).toarray()

Hasilnya:

array([[1, 0, 1, 0, 1, 1],

[1, 1, 0, 1, 0, 0]])

Sekarang, kita dapat melihat vektor fitur yang dihasilkan untuk setiap kalimat berdasarkan vocabulary sebelumnya. Misalnya, jika kita melihat item pertama, kita dapat melihat bahwa kedua vektor memiliki 1 di sana. Ini berarti bahwa kedua kalimat memiliki satu kemunculan John, yang berada pada tempat pertama dalam Vocabulary.

Ini dianggap model Bag-of-words (BOW), yang merupakan cara umum dalam NLP untuk membuat vektor dari teks. Setiap dokumen direpresentasikan sebagai vektor. Kita dapat menggunakan vektor ini sekarang sebagai feature vector untuk model machine learning. Ini membawa kita ke bagian selanjutnya, mendefinisikan model dasar.

Mendefinisikan Model Baseline

Saat kita bekerja dengan machine learning, satu langkah penting adalah menentukan model dasar. Ini biasanya melibatkan model sederhana, yang kemudian digunakan sebagai perbandingan dengan model yang lebih maju yang ingin kita uji. Dalam hal ini, kita akan menggunakan model dasar untuk membandingkannya dengan metode yang lebih maju yang melibatkan (deep) neural network.

Pertama, kita akan membagi data menjadi set training dan testing yang akan memungkinkan kita untuk mengevaluasi akurasi dan melihat apakah model kita dapat digeneralisasikan dengan baik. Ini berarti apakah model tersebut mampu berkinerja baik pada data yang belum pernah dilihat sebelumnya. Ini adalah cara untuk melihat apakah modelnya overfitting (cocok).

Overfitting adalah ketika model dilatih terlalu baik pada data training. Kita ingin menghindari overfitting, karena ini berarti model sebagian besar hanya menghafal data pelatihan. Ini akan menjelaskan akurasi yang besar dengan data training tetapi akurasi yang rendah dalam data testing.

Kita mulai dengan mengambil data set Yelp yang kita ekstrak dari kumpulan data gabungan. Dari sana, kita mengambil kalimat dan label. Nilai .values mengembalikan array NumPy daripada objek series Pandas yang dalam konteks ini akan lebih mudah digunakan:

from sklearn.model_selection import train_test_split

df_yelp = df[df['source'] == 'yelp']

sentences = df_yelp['sentence'].values

y = df_yelp['label'].values

sentences_train, sentences_test, y_train, y_test = train_test_split(

sentences, y, test_size=0.25, random_state=1000)

Di sini kita akan menggunakan lagi model BOW sebelumnya untuk membuat vektor kalimat. Kita dapat menggunakan lagi CountVectorizer untuk tugas ini. Karena kita mungkin tidak memiliki data pengujian yang tersedia selama testing, kikta dapat membuat Vocabulary hanya menggunakan data training. Dengan menggunakan Vocabulary ini, kita dapat membuat feature vector untuk setiap kalimat dari rangkaian training dan testing:

from sklearn.feature_extraction.text import CountVectorizer vectorizer = CountVectorizer() vectorizer.fit(sentences_train) X_train = vectorizer.transform(sentences_train) X_test = vectorizer.transform(sentences_test) X_train

Hasilnya:

<750x1714 sparse matrix of type '<class 'numpy.int64'>'

with 7368 stored elements in Compressed Sparse Row format>

Kita dapat melihat bahwa feature vector yang dihasilkan memiliki 750 sampel yang merupakan jumlah sampel training yang kita miliki setelah split train-test. Setiap sampel memiliki 1714 dimensi yang merupakan ukuran Vocabulary. Kita juga dapat melihat bahwa kita mendapatkan matriks sparce (yang banyak nol-nya). Ini adalah tipe data yang dioptimalkan untuk matriks dengan hanya beberapa elemen non-zero (tidak nol). Untuk menghemat memory, kita hanya akan memperhatikan elemen yang non-zero saja.

CountVectorizer melakukan tokenization yang memisahkan kalimat menjadi satu set token seperti yang kita lihat sebelumnya dalam Vocabulary. Ini juga menghilangkan tanda baca dan karakter khusus dan dapat menerapkan preprocessing lainnya untuk setiap kata. Jika mau, kita dapat menggunakan tokenizer khusus dari perpustakaan NLTK dengan CountVectorizer atau menggunakan sejumlah penyesuaian yang dapat kita eksplorasi untuk meningkatkan kinerja model kita.

Catatan: Ada banyak parameter tambahan untuk CountVectorizer() yang kita lupakan untuk digunakan di sini, seperti menambahkan ngram, karena tujuan awalnya adalah untuk membangun model baseline sederhana. Tokeb pattern itu sendiri default ke token_pattern = ’(?U)\b \w\w+\b’, yang merupakan pola regex yang mengatakan, "sebuah kata adalah 2 atau lebih karakter kata Unicode yang dikelilingi oleh batas kata.".

Model klasifikasi yang akan kita gunakan adalah regresi logistik yang merupakan model linier sederhana namun kuat yang secara matematis merupakan bentuk regresi antara 0 dan 1 berdasarkan feature vector input. Dengan menentukan nilai cutoff (secara default 0,5), model regresi digunakan untuk klasifikasi. Anda dapat menggunakan library scikit-learn yang menyediakan classifier LogisticRegression:

Model klasifikasi yang akan kita gunakan adalah regresi logistik yang merupakan model linier sederhana namun kuat yang secara matematis merupakan bentuk regresi antara 0 dan 1 berdasarkan feature vector input. Dengan menentukan nilai cutoff (secara default 0,5), model regresi digunakan untuk klasifikasi. Anda dapat menggunakan library scikit-learn yang menyediakan classifier LogisticRegression:

from sklearn.linear_model import LogisticRegression

classifier = LogisticRegression()

classifier.fit(X_train, y_train)

score = classifier.score(X_test, y_test)

print("Accuracy:", score)

Hasilnya:

Accuracy: 0.796

Kita dapat melihat bahwa logistic regression mencapai 79,6% yang mengesankan, tetapi mari kita lihat bagaimana kinerja model ini pada set data lain yang kita miliki. Dalam skrip ini, kita melakukan dan mengevaluasi seluruh proses untuk setiap set data yang kita miliki:

for source in df['source'].unique():

df_source = df[df['source'] == source]

sentences = df_source['sentence'].values

y = df_source['label'].values

sentences_train, sentences_test, y_train, y_test = train_test_split(

sentences, y, test_size=0.25, random_state=1000)

vectorizer = CountVectorizer()

vectorizer.fit(sentences_train)

X_train = vectorizer.transform(sentences_train)

X_test = vectorizer.transform(sentences_test)

classifier = LogisticRegression()

classifier.fit(X_train, y_train)

score = classifier.score(X_test, y_test)

print('Accuracy for {} data: {:.4f}'.format(source, score))

Here’s the result:

Accuracy for yelp data: 0.7960 Accuracy for amazon data: 0.7960 Accuracy for imdb data: 0.7487

Bagus! Kita dapat melihat bahwa model yang cukup sederhana ini menghasilkan akurasi yang cukup baik. Akan menarik untuk melihat apakah kita dapat memperbaiki model ini. Pada bagian selanjutnya, kita akan mengenal (Deep) Neural Network dan bagaimana menerapkannya pada klasifikasi teks.

(Deep) Neural Networks

Kita mungkin telah mengalami beberapa kekaguman dan ketakutan terkait dengan kecerdasan buatan dan deep learning. Kita mungkin telah menemukan beberapa artikel yang membingungkan atau TED talk yang khawatir membicarakan pendekatan singularitas atau mungkin kita melihat robot backflipping dan kita bertanya-tanya apakah kehidupan di belantara sebetulnya demikian menarik.

Pada catatan yang lebih ringan, semua peneliti AI sepakat bahwa mereka tidak setuju satu sama lain ketika AI akan melebihi kinerja tingkat Manusia. Dalam tulisan ini kita masih punya waktu.