LLM: ubuntu 24.04 ollama instalasi CUDA

Perintah instalasi CUDA core versi 12.8 pada ubuntu versi 24.04:

sudo docker run -d -p 3000:8080 --gpus all --add-host=host.docker.internal:host-gateway -v open-webui:/app/backend/data --name open-webui --restart always ghcr.io/open-webui/open-webui:cuda

Isi tambahan docker-compose agar dapat memanfaatkan GPU: ollama:

container_name: ollama

image: ollama/ollama:latest

runtime: nvidia

environment:

- NVIDIA_VISIBLE_DEVICES=all

- NVIDIA_DRIVER_CAPABILITIES=compute,utility

- CUDA_VISIBLE_DEVICES=0

- LOG_LEVEL=debug

deploy:

resources:

reservations:

devices:

- driver: nvidia

capabilities: [gpu]

count: all

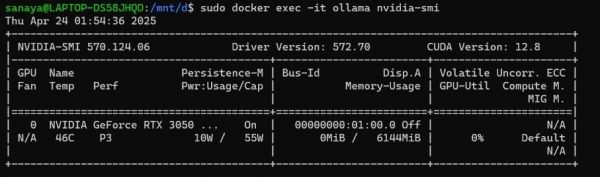

Untuk mengetahui apakah model sudah berhasil memanfaatkan GPU:

sudo docker exec -it ollama nvidia-smi

Sumber Informasi:

1. https://github.com/open-webui/open-webui

2. https://developer.nvidia.com/cuda-downloads

Catatan tambahan: Aktivasi CUDA core nvidia untuk akselerasi AI hanya bisa dilakukan pada arsitektur nvidia AMPERE (3000 series) ke atas seperti Ada Lovelace (4000 series) dan Blackwell (5000 series).

Kemudian saya juga menyertakan gambar jika memang model AI telah berhasil terhubung dengan GPU dan berhasil memanfaatkan CUDA Core-nya untuk akselerasi dalam hal membuat jawaban.

Kiranya itu saja yang dapat saya sampaikan melalui pesan ini, terimakasih atas waktu dan kesempatan yang telah diberikan Prof.