Difference between revisions of "Data Center: How to design and build a data center"

Onnowpurbo (talk | contribs) |

Onnowpurbo (talk | contribs) |

||

| (17 intermediate revisions by the same user not shown) | |||

| Line 8: | Line 8: | ||

| − | == | + | ==Apa komponen utama data center?== |

| − | + | Ada dua aspek utama untuk data center mana pun: fasilitas, dan infrastruktur TI yang berada di dalam fasilitas. Aspek-aspek ini hidup berdampingan dan bekerja sama, tetapi dapat didiskusikan secara terpisah. | |

| − | + | Fasilitas. Fasilitas adalah bangunan fisik yang digunakan untuk data center. Dalam istilah paling sederhana, data center hanyalah ruang terbuka besar tempat infrastruktur akan digunakan. Meskipun hampir semua ruangan memiliki potensi untuk mengoperasikan sejumlah infrastruktur TI, fasilitas yang dirancang dengan baik mempertimbangkan berbagai faktor berikut: | |

| − | * Space. | + | * Space. Harus ada ruang lantai yang cukup -- ukuran meter persegi -- untuk menampung semua infrastruktur TI yang ingin diterapkan bisnis saat ini dan di masa mendatang. Ruang harus terletak di situs yang dipertimbangkan dengan baik dengan pajak dan akses yang terjangkau. Ruang sering dibagi untuk mengakomodasi berbagai tujuan atau jenis penggunaan. |

| − | * Power. | + | * Power. Harus ada daya yang memadai -- dalam watt, seringkali sebanyak 100 megawatt -- untuk mengoperasikan semua infrastruktur TI. Listrik harus terjangkau, bersih -- artinya bebas dari fluktuasi atau gangguan -- dan dapat diandalkan. Daya terbarukan dan tambahan/tambahan harus disertakan. |

| − | * Cooling. | + | * Cooling. Sejumlah besar daya yang dikirimkan ke pusat data diubah menjadi komputasi -- yaitu, kerja -- dan banyak panas, yang harus dihilangkan dari infrastruktur TI menggunakan sistem HVAC konvensional, serta teknologi pendinginan nonkonvensional lainnya. |

| − | * Security. | + | * Security. Mempertimbangkan nilai pusat data dan kepentingan kritisnya bagi bisnis, pusat data harus menyertakan akses terkontrol menggunakan berbagai taktik, mulai dari akses badge karyawan hingga pengawasan video. |

| − | * Management. | + | * Management. Pusat data modern biasanya menggabungkan building management system (BMS) yang dirancang untuk membantu pemimpin TI dan bisnis mengawasi lingkungan pusat data secara real time, termasuk pengawasan suhu, kelembapan, tingkat daya dan pendinginan, serta pencatatan akses dan keamanan. |

| − | + | Infrastruktur. Infrastruktur mewakili rangkaian peralatan TI yang luas yang digunakan di dalam fasilitas. Ini adalah peralatan yang menjalankan aplikasi dan memberikan layanan kepada bisnis dan penggunanya. Infrastruktur TI tipikal mencakup komponen-komponen berikut: | |

| − | * | + | * Server. Komputer ini menghosting aplikasi perusahaan dan melakukan tugas komputasi. |

| − | * Storage. | + | * Storage. Subsistem, seperti larik disk, digunakan untuk menyimpan dan melindungi aplikasi dan data bisnis. |

| − | * Networking. | + | * Networking. Perlengkapan yang diperlukan untuk membuat jaringan bisnis meliputi sakelar, router, firewall, dan elemen keamanan siber lainnya. |

| − | * | + | * Cable and rack. Berkilometer kabel menghubungkan perlengkapan TI, dan rak server fisik digunakan untuk mengatur server dan perlengkapan lainnya di dalam ruang fasilitas. |

| − | * Backup power. Uninterruptible power supply (UPS), flywheel | + | * Backup power. Uninterruptible power supply (UPS), flywheel, dan sistem daya darurat lainnya sangat penting untuk memastikan perilaku infrastruktur yang teratur jika terjadi gangguan daya utama. |

| − | * Management | + | * Management platform. Satu atau lebih data center infrastructure management (DCIM) diperlukan untuk mengawasi dan mengelola pelaporan infrastruktur TI tentang kesehatan sistem, ketersediaan, kapasitas, dan konfigurasi. |

| − | + | Ketika sebuah bisnis memutuskan untuk merancang dan membangun pusat data, fokus alaminya adalah pada desain dan konstruksi fasilitas tersebut. Namun para pemimpin TI juga harus mempertimbangkan infrastruktur yang akan masuk ke fasilitas untuk memvalidasi proyek. | |

| − | == | + | ==Bagaimana merancang data center== |

| − | + | Tidak ada standar yang diwajibkan untuk desain atau konstruksi data center; data center dimaksudkan agar sesuai dengan kebutuhan unik bisnis secara keseluruhan, bukan sebaliknya. Namun, tujuan utama dari standar apa pun adalah untuk membangun platform yang terbaik. Bermacam-macam standar data center saat ini ada, dan bisnis dapat menggabungkan satu atau lebih standar -- atau bagian dari standar -- ke dalam proyek data center. Standar membantu memastikan perhatian yang memadai diberikan pada faktor-faktor ini, antara lain: | |

| − | * | + | * desain konseptual; |

| − | * | + | * tata letak dan perencanaan ruang; |

| − | * | + | * persyaratan konstruksi bangunan; |

| − | * | + | * masalah keamanan fisik; |

| − | * | + | * bangunan internal (mekanik, listrik, pipa ledeng dan sistem kebakaran); |

| − | * | + | * operasi dan workflow; Dan |

* maintenance. | * maintenance. | ||

| − | + | Di bawah ini adalah beberapa standar desain dan infrastruktur pusat data utama: | |

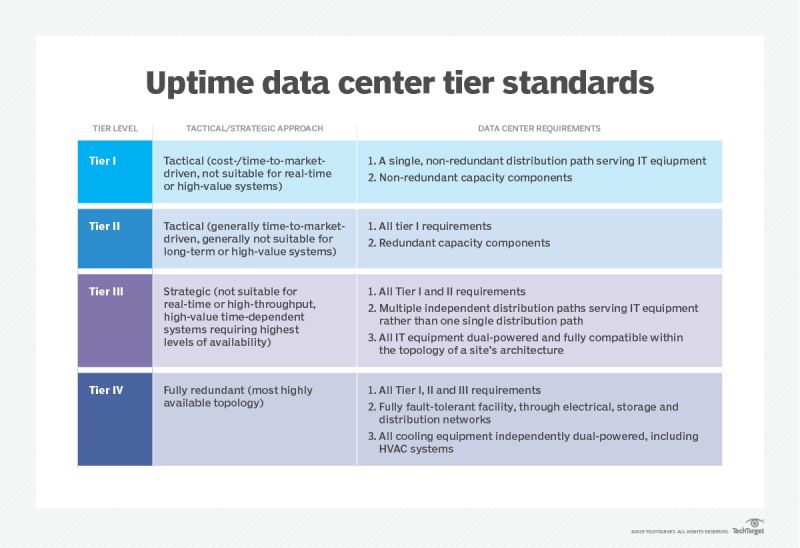

| − | * Uptime Institute Tier Standard. | + | * Uptime Institute Tier Standard. Uptime Institute Tier Standard berfokus pada desain, konstruksi, dan commissioning data center, dan digunakan untuk menentukan ketahanan fasilitas terkait dengan empat tingkat redundansi/keandalan. |

| − | * ANSI/TIA 942-B. | + | * ANSI/TIA 942-B. Standar ini melibatkan perencanaan, desain, konstruksi dan komisioning perdagangan bangunan, serta proteksi kebakaran, TI, dan pemeliharaan. Ini juga menggunakan empat tingkat peringkat keandalan, yang diterapkan oleh para profesional bersertifikasi BICSI. |

| − | * EN 50600 | + | * EN 50600 seri. Serangkaian standar ini berfokus pada kabel IT dan desain jaringan serta memiliki berbagai konsep redundansi dan keandalan infrastruktur yang secara longgar didasarkan pada Standar Tier Uptime Institute. |

| − | * | + | * ASHRA. ASHRAE guideline -- yang tidak khusus untuk TI atau data center -- terkait dengan desain dan penerapan pemanas, ventilasi, penyejuk udara, pendingin, dan bidang terkait. |

| − | + | [[File:Whatis-uptime-data-center-tier-standards.png|center|800px|thumb]] | |

| − | |||

| − | + | Selain itu, ada banyak variasi peraturan dan standar operasional yang dapat diterapkan pada data center. Standar peraturan termasuk HIPAA, Sarbanes-Oxley Act, SAS 70 Tipe I atau II dan Gramm-Leach-Bliley Act. Standar operasional dapat mencakup ISO 9000 untuk kualitas, ISO 14000 untuk manajemen lingkungan, ISO 27001 untuk keamanan informasi, Standar Keamanan Data Industri Kartu Pembayaran untuk keamanan kartu pembayaran dan EN 50600-2-6 tentang manajemen dan informasi operasional. | |

| − | + | Standar membantu memastikan desain, konstruksi, dan pengoperasian data center yang tepat. Selain itu, penerapan dan dokumentasi yang cermat atas penggunaan standar yang relevan dapat membantu bisnis memastikan kepatuhan yang memadai melalui ketahanan fasilitas, manajemen, dan persiapan kelanjutan bisnis yang tepat. | |

| − | == | + | ==Ruang fisik dan organisasi data center== |

| − | + | Pada intinya, fasilitas data center tidak lebih dari ruang terbuka yang besar -- sebuah gudang yang disiapkan dengan hati-hati yang dimaksudkan untuk menjadi tuan rumah dan mengoperasikan infrastruktur TI yang menuntut. Meskipun data center kelas perusahaan dapat menjadi pekerjaan yang besar dan kompleks, masalah utamanya adalah masalah ruang sederhana yang dinyatakan dalam meter persegi. | |

| − | + | Mungkin masalah ruang yang paling signifikan dan membingungkan adalah ukuran data center yang tepat untuk bisnis. Data Center sangat mahal: terlalu kecil, dan data center mungkin tidak memenuhi kebutuhan bisnis saat ini atau di masa depan; terlalu besar, dan modal yang sangat besar dapat disia-siakan untuk menyediakan ruang yang tidak terpakai. Sangat penting untuk membangun fasilitas yang menawarkan kapasitas pertumbuhan namun pemanfaatan yang optimal. Ukuran data center terkadang dianggap sebagai seni tersendiri. Banyak faktor lain yang perlu dipertimbangkan dalam data center termasuk yang berikut: | |

| − | * Lighting. | + | * Lighting. Sebagian besar pencahayaan data data redup atau mati tanpa kehadiran manusia. |

| − | * | + | * Suhu. Tuntutan pendinginan dapat menjaga suhu tetap rendah, sehingga manusia mungkin membutuhkan pakaian pelindung. |

| − | * Noise. | + | * Noise. Kipas pendingin di lusinan -- bahkan ratusan -- server dapat menghasilkan hiruk-pikuk yang membutuhkan perlindungan pendengaran. |

| − | * | + | * Berat. Peralatan berat, dan lantai harus dirancang untuk menahan beban yang ekstrim. Pertimbangan berat khusus mungkin diperlukan untuk lantai yang ditinggikan yang digunakan untuk menangani aliran udara pendingin. |

| − | + | Di luar ruang fisik, desain data center harus menyertakan pertimbangan cermat terhadap lokasi dan tata letak peralatan -- yaitu, di mana infrastruktur TI ditempatkan di dalam fasilitas. Fitur paling umum dari setiap tata letak data center adalah rak server -- atau, singkatnya, rak. Rak adalah rangka logam kosong dengan opsi penspasian dan pemasangan standar yang dimaksudkan untuk menampung perlengkapan TI yang dipasang di rak standar, seperti server, subsistem penyimpanan, perlengkapan jaringan, pemasangan kabel, sistem daya tambahan seperti perangkat UPS, dan opsi I/O seperti keyboard dan monitor untuk akses administratif. | |

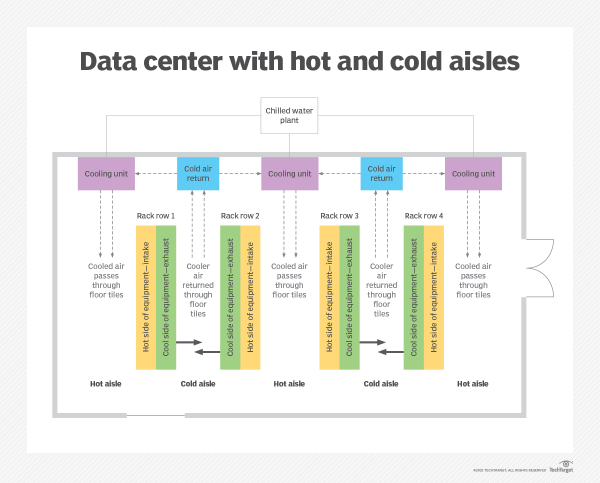

| − | + | Rak juga memainkan peran penting dalam skema pendinginan data center. Rak roda gigi umumnya diatur untuk membuat lorong panas dan dingin yang dapat meningkatkan efisiensi pendinginan dengan memungkinkan masuknya udara dingin ke lorong dingin, yang dipanaskan oleh roda gigi dan dikirim ke lorong panas, di mana udara panas dapat dihilangkan secara efektif dari ruangan. Pengaturan lorong juga dapat membantu memfasilitasi pengenalan pintu tambahan dan langkah-langkah keamanan di ujung setiap lorong untuk membatasi akses manusia. | |

| − | |||

| − | + | ==Keamanan data center== | |

| + | Keamanan data center biasanya melibatkan tiga aspek berbeda yaitu keamanan akses, keamanan fasilitas, dan keamanan siber. | ||

| − | + | Akses keamanan. Setiap pembahasan fasilitas data center harus melibatkan pertimbangan keamanan fisik. Keamanan fisik adalah pengelolaan personel manusia dan perlindungan fasilitas fisik serta infrastruktur TI-nya. Ketika diterapkan dengan benar, keamanan memastikan bahwa hanya personel yang berwenang yang memiliki akses ke fasilitas dan perlengkapan, dan bahwa semua aktivitas manusia didokumentasikan. Keamanan dapat melibatkan serangkaian tindakan berikut: | |

| − | |||

| − | + | * akses badge ke dalam dan di sekitar fasilitas (termasuk area peralatan); | |

| + | * akses kunci ke rak dan server tertentu; | ||

| + | * log untuk akses karyawan dan pengunjung/vendor; | ||

| + | * pendamping untuk non-karyawan; | ||

| + | * CCTV; Dan | ||

| + | * petugas keamanan di tempat. | ||

| − | + | Keamanan fasilitas. Keamanan fisik juga mencakup integritas lingkungan data center, termasuk suhu, kelembapan, dan kondisi asap/kebakaran/banjir. Aspek perlindungan data center ini sering ditangani oleh BMS yang memantau dan melaporkan kondisi lingkungan atau darurat kepada pengelola gedung. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | Keamanan cyber. Cybersecurity berfokus pada pengendalian akses ke data perusahaan dan aplikasi yang dihosting dalam infrastruktur TI data center. Cybersecurity dimaksudkan untuk memastikan bahwa hanya pengguna yang diautentikasi dengan benar yang dapat mengakses data atau menggunakan aplikasi, dan setiap pelanggaran dilaporkan dan segera ditangani. Misalnya, keamanan fisik mencegah manusia menyentuh disk di pusat data, sementara keamanan siber mencegah manusia yang sama mengakses data di disk dari jarak ratusan mil di seluruh jaringan. Cybersecurity menggunakan campuran antimalware, manajemen konfigurasi, deteksi/pencegahan intrusi, pencatatan aktivitas, dan alat lain untuk mengawasi aktivitas jaringan dan mengidentifikasi potensi ancaman. | |

| − | |||

| − | Cybersecurity | ||

==Data center power and performance demands== | ==Data center power and performance demands== | ||

| Line 123: | Line 119: | ||

A dual conversion UPS design when utility power fails. | A dual conversion UPS design when utility power fails. | ||

| − | ==Data center cooling | + | ==Data center cooling system== |

| − | + | Daya yang dialirkan ke data center diterjemahkan ke dalam pekerjaan yang dilakukan oleh infrastruktur TI, serta produk sampingan yang tidak diinginkan: panas. Panas ini harus dihilangkan dari server dan sistem, dan kemudian dikeluarkan dari data center. Akibatnya, sistem pendingin menjadi perhatian penting bagi perancang dan operator data center. | |

| − | + | Ada dua masalah pendinginan utama. Masalah pertama adalah jumlah pendinginan yang diperlukan, yang pada akhirnya menentukan ukuran atau kapasitas subsistem HVAC pusat data. Namun, perancang harus membuat terjemahan dari permintaan daya data center dalam watt (W) ke kapasitas pendinginan yang diukur dalam ton (t) -- yaitu, jumlah energi panas yang dibutuhkan untuk melelehkan satu ton es pada suhu 0 derajat Celsius (32 derajat Fahrenheit) dalam satu jam . Perhitungan tipikal pertama membutuhkan konversi watt menjadi British thermal unit (BTU) per jam, yang kemudian dapat dikonversi menjadi ton: | |

W x 3.41 = BTU/hour | W x 3.41 = BTU/hour | ||

| Line 132: | Line 128: | ||

BTU/hour / 12,000 = t | BTU/hour / 12,000 = t | ||

| − | + | Kuncinya adalah memahami kebutuhan daya data center dalam watt dan skalabilitas terencana, jadi penting untuk mengukur subsistem pendingin gedung dengan ukuran yang tepat. Jika sistem pendingin terlalu kecil, data center tidak dapat menampung atau menskalakan jumlah infrastruktur TI yang diharapkan. Jika sistem pendingin terlalu besar, hal itu menimbulkan utilitas yang mahal dan tidak efisien untuk bisnis. | |

| + | |||

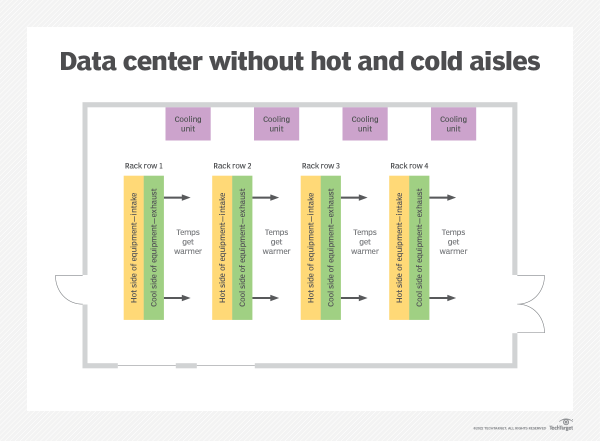

| + | Masalah pendinginan kedua untuk data center adalah penggunaan dan penanganan udara dingin dan panas yang efisien. Untuk ruang manusia biasa, hanya memasukkan udara dingin dari satu ventilasi dan kemudian membuang udara hangat dari ventilasi lain di tempat lain di ruangan itu menyebabkan pencampuran dan rata-rata suhu yang menghasilkan kenyamanan manusia yang memadai. Tapi pendekatan rumah dan kantor yang umum ini tidak bekerja dengan baik di data center, di mana rak peralatan menghasilkan panas yang ekstrim di ruang yang terkonsentrasi. Rak gigi yang sangat panas membutuhkan aplikasi udara dingin yang hati-hati, dan kemudian dengan hati-hati menahan dan membuang knalpot yang panas. Perancang data center harus berhati-hati untuk menghindari pencampuran udara panas dan dingin yang membuat ruang ber-AC manusia begitu nyaman. | ||

| + | |||

| + | Desainer secara rutin mengatasi penanganan udara ruang server melalui penggunaan skema penahanan, seperti tata letak lorong panas/dingin. Pertimbangkan dua baris rak peralatan, di mana bagian belakang saling berhadapan (lihat diagram kedua di bawah). Udara dingin dari sistem HVAC dimasukkan ke lorong di depan setiap baris rak, sementara udara panas dikumpulkan dan dibuang dari lorong panas umum. Penghalang fisik tambahan ditambahkan untuk mencegah udara panas bercampur dengan udara dingin. Skema penahanan tersebut menawarkan penggunaan kapasitas HVAC yang sangat efisien. | ||

| + | |||

| + | [[File:Data center without hot and cold aisles-f.png|center|600px|thumb]] | ||

| − | + | [[File:Data center with hot and cold aisles-f.png|center|600px|thumb]] | |

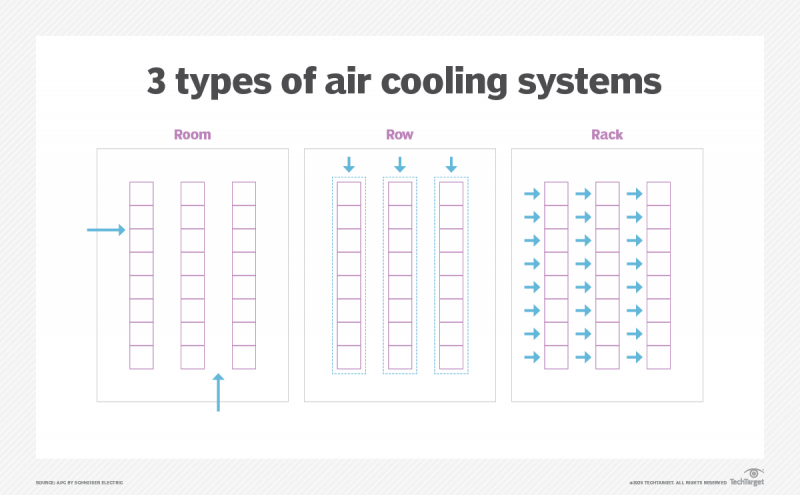

| − | + | Pendekatan lain untuk pendinginan termasuk sistem pendingin udara ujung baris dan atas rak, yang memasukkan udara dingin ke bagian-bagian dari deretan rak dan membuang udara panas ke lorong panas. | |

| − | + | Beberapa data center bahkan mengadopsi teknologi pendingin cair baru yang menenggelamkan peralatan TI dalam bak berisi cairan dingin yang netral secara elektrik, seperti minyak mineral. Chiller cair berukuran kecil dan hemat daya, dan cairan dapat menawarkan efisiensi perpindahan panas berkali-kali lipat dibandingkan pendinginan udara. Namun, pendinginan cair menghadapi tantangan lain, termasuk kebocoran/banjir, korosi sebagian atau kerentanan terhadap intrusi cairan, penyaringan dan kebersihan cairan, dan keselamatan manusia. | |

| − | |||

| − | |||

| − | |||

| − | |||

| − | + | [[File:Data center-liquid vs air cooling-f.png|center|800px|thumb]] | |

| − | + | Diagram ini menunjukkan konsep dasar arsitektur pendinginan berbasis ruangan, baris, dan rak. Panah biru menunjukkan hubungan jalur pasokan pendingin utama ke ruangan. | |

| − | |||

==Data center efficiency and sustainability== | ==Data center efficiency and sustainability== | ||

| + | Kekhawatiran saat ini tentang dampak lingkungan dari emisi CO2 dari pembangkit listrik telah mendorong banyak organisasi untuk memberikan penekanan baru pada efisiensi dan keberlanjutan data center. | ||

| − | + | Efisiensi pada dasarnya adalah ukuran kerja yang dilakukan versus jumlah energi yang digunakan untuk melakukan kerja itu. Jika semua energi input berhasil diubah menjadi kerja yang bermanfaat, efisiensinya adalah 100%. Jika tidak ada energi input yang menghasilkan kerja yang berhasil, efisiensinya adalah 0%. Bisnis berupaya meningkatkan efisiensi hingga 100% sehingga setiap dolar yang dihabiskan untuk energi mendorong pekerjaan data center yang bermanfaat. | |

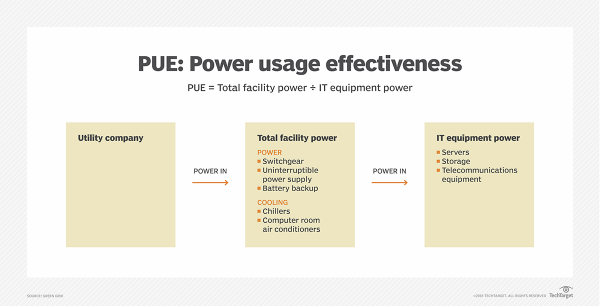

| − | + | Tindakan seperti power usage effectiveness (PUE) tersedia untuk membantu organisasi mengukur efisiensi. PUE dihitung sebagai daya yang masuk ke pusat data dibagi dengan daya yang digunakan dalam infrastruktur TI. Ini menghasilkan rasio sederhana yang mendekati 1,0 saat efisiensi mendekati 100%, dan persentase yang sesuai dinyatakan sebagai efisiensi infrastruktur pusat data. Bisnis dapat meningkatkan rasio PUE dengan mengurangi jumlah energi dalam penggunaan non-IT, seperti mengurangi pencahayaan dan pendinginan di ruang non-IT dan menerapkan desain bangunan hemat energi lainnya. | |

| − | + | [[File:Data center-pue.png|center|600px|thumb|Power usage effectivenes adalah metrik yang digunakan untuk menilai efisiensi data center]] | |

| − | + | Keberlanjutan adalah perhatian lain. Pembangkit listrik menciptakan polusi yang diyakini mendorong perubahan iklim dan mengurangi kesehatan planet ini. Menciptakan data center yang berkelanjutan atau hijau berarti mengupayakan emisi karbon nol bersih untuk daya yang menggerakkan pusat data. Nol bersih berarti energi diperoleh dari sumber terbarukan yang menambahkan nol CO2 ke atmosfer. | |

| − | |||

| − | |||

| + | Dalam beberapa kasus, bisnis dapat memilih untuk mendekati nol bersih dengan menggunakan daya dari sumber yang tidak mencemari, seperti pembangkit tenaga surya atau angin. Dalam kasus lain, daya dapat dibeli dari penyedia daya yang mampu menangkap atau memulihkan jumlah setara CO2 yang dipancarkan dalam produksi energi, sehingga menghasilkan emisi nol bersih. Untuk mencapai net zero, bisnis harus menerapkan konservasi energi, efisiensi energi -- seperti inisiatif PUE -- dan sumber energi terbarukan tanpa polusi. | ||

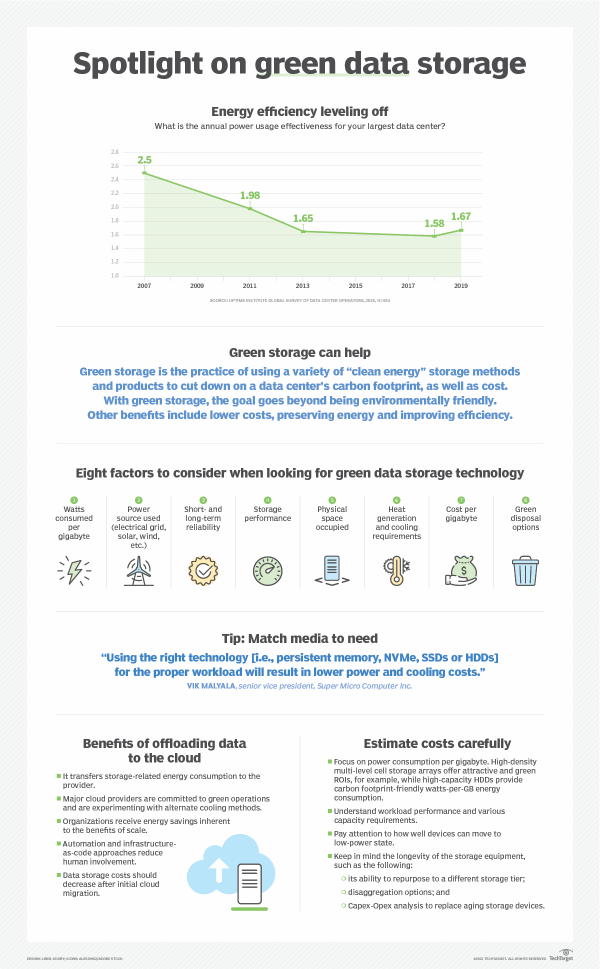

| − | + | [[File:Storage-spotlight on green data storage-i.png|center|600px|thumb]] | |

| − | + | Kurangi konsumsi energi penyimpanan data untuk menjalankan data center yang lebih ramah lingkungan. | |

| − | |||

| − | ==Data center design best | + | ==Data center design best practice== |

| − | + | Tidak ada cara tunggal untuk merancang sebuah data center, dan ada banyak sekali desain yang memenuhi kebutuhan unik setiap bisnis. Tetapi strategi berikut dapat menghasilkan desain data center dengan efisiensi dan keberlanjutan yang unggul: | |

| − | * Measure power efficiency. | + | * Measure power efficiency. Operator pusat data tidak dapat mengelola apa yang tidak mereka ukur, jadi gunakan metrik seperti PUE untuk mengawasi efisiensi data center. PUE harus menjadi pengukuran berkelanjutan yang dilakukan pada interval yang sering, sepanjang tahun, karena musim dan cuaca dapat memengaruhi penggunaan daya. |

| − | * Revisit airflow. | + | * Revisit airflow. Pendinginan sangat penting untuk pengoperasian infrastruktur TI yang aman, tetapi aliran udara harus dikelola dan dioptimalkan. Ini dapat mencakup pembatasan pencampuran udara panas/dingin, menggunakan skema penahanan lorong panas/dingin dan bahkan menggunakan pelat blanking untuk menutup bukaan rak yang tidak terpakai, yang mencegah udara dingin mengalir ke tempat yang tidak mendinginkan peralatan apa pun. |

| − | * Raise the temperature. | + | * Raise the temperature. Semakin dingin ruang server, semakin haus daya dan mahal. Daripada menjaga ruang server lebih dingin, evaluasi efek dari menaikkan suhu sebenarnya. Misalnya, daripada menjalankan lorong dingin pada suhu 16 hingga 22 derajat Celsius, pertimbangkan menjalankan lorong dingin pada suhu 25 hingga 27 derajat Celsius. Sebagian besar perlengkapan IT dapat mentolerir suhu tinggi dengan cara ini. |

| − | * Try alternative cooling. | + | * Try alternative cooling. Sistem HVAC mungkin standar untuk pusat data, tetapi pertimbangkan cara untuk mengurangi atau menghilangkan ketergantungan pada HVAC konvensional. Misalnya, data center di iklim yang lebih dingin dapat mengurangi penggunaan HVAC dan memasukkan udara luar yang lebih sejuk -- disebut pendinginan gratis -- ke dalam fasilitas. Demikian pula, HVAC dapat dilengkapi atau diganti dengan pendingin berpendingin air - yaitu, economizers - atau teknologi pertukaran panas lainnya yang menggunakan energi jauh lebih sedikit. |

| − | * Improve power distribution. | + | * Improve power distribution. Efisiensi daya data center sering kali hilang karena inefisiensi dalam penanganan daya dan perangkat distribusi, seperti transformator peralatan, PDU, dan perlengkapan UPS. Gunakan roda gigi distribusi daya berefisiensi tinggi dan minimalkan roda gigi -- keduanya menghasilkan langkah yang lebih sedikit dan peluang kehilangan. |

| − | == | + | ==Tantangan desain data center== |

| − | + | Meskipun tidak ada formula tunggal yang seragam untuk desain dan konstruksi data center, ada banyak tantangan abadi yang dihadapi oleh perancang dan operator data center. Di bawah ini adalah beberapa pertimbangan dan tantangan yang luas: | |

| − | * Scalability. | + | * Scalability. Data center adalah instalasi jangka panjang yang dapat tetap beroperasi selama beberapa dekade, tetapi data center yang beroperasi saat ini mungkin berbeda secara signifikan dari data center yang beroperasi satu atau dua dekade dari sekarang. Desainer harus mempertimbangkan cara menangani beban kerja dan layanan saat ini, sambil juga mempertimbangkan bagaimana sumber daya tersebut harus diskalakan dengan baik ke masa depan. Tantangannya adalah menyediakan ruang untuk pertumbuhan ruang, daya, dan pendinginan sambil mengurangi biaya kapasitas tersebut hingga dibutuhkan. |

| − | * Flexibility. | + | * Flexibility. Pusat data sedikit mirip dengan lantai produksi yang berat: Peralatan sudah terpasang tetapi hampir tidak mungkin untuk dipindahkan dan diubah seiring berkembangnya permintaan. Ketidakmampuan untuk memindahkan gigi dan menggeser lorong dapat mencegah bisnis beradaptasi dan berubah untuk memenuhi permintaan bisnis baru. Tantangannya adalah memenuhi kebutuhan akan perubahan tanpa downtime atau desain ulang yang mahal dan memakan waktu. |

| − | * Resilience. | + | * Resilience. Sebuah bisnis bergantung pada data center-nya. Jika data center tidak berfungsi, bisnis tidak berfungsi. Gangguan listrik, gangguan jaringan, bencana lingkungan dan bahkan peretasan dan tindakan jahat lainnya dapat melumpuhkan data center. Desainer menghadapi tantangan untuk memahami ancaman yang paling umum dan merancang ketahanan yang tepat untuk menghadapi ancaman tersebut. |

| − | * Change. | + | * Change. Teknologi komputasi baru dan persyaratan baru selalu dikembangkan dan diperkenalkan. Perancang data center harus mempertimbangkan cara mengadaptasi dan menggabungkan perubahan yang sering tidak terduga tanpa perlu mendesain ulang infrastruktur TI secara mendasar untuk mengakomodasi setiap perubahan. |

| − | ==Data center infrastructure management software and | + | ==Data center infrastructure management software and tool== |

| − | Data | + | Data center adalah organisme kompleks yang memerlukan pemantauan dan manajemen berkelanjutan baik di tingkat fasilitas maupun infrastruktur TI. Operator data center biasanya menggunakan alat DCIM untuk memberikan perspektif ke dalam pengoperasian fasilitas dan infrastruktur. Serangkaian tugas manajemen umum yang diperlukan untuk mengoperasikan data center mencakup hal-hal berikut: |

| − | + | * Pengamatan dan pengawasan. Tugas observasi meliputi pemantauan daya, suhu dan kelembaban di dalam fasilitas. Pengamatan dalam infrastruktur dapat mencakup kapasitas yang tersedia, artinya sistem mana yang digunakan dan mana yang gratis; kesehatan aplikasi untuk memantau operasi yang benar dari beban kerja utama perusahaan; dan waktu aktif atau ketersediaan secara keseluruhan. Tugas observasi biasanya dikaitkan dengan sistem peringatan dan tiket untuk memprioritaskan dan memulihkan masalah saat terdeteksi. | |

| − | + | * Persiapan dan perbaikan. Manajemen data center juga melibatkan tugas persiapan, seperti pemulihan bencana dan proses pencadangan, serta kemampuan migrasi beban kerja untuk memungkinkan tugas layanan sistem tepat waktu. Tugas perbaikan meliputi servis rutin, bersama dengan peningkatan sistem berkala dan pemecahan masalah dan perbaikan sistem ad hoc. | |

| − | + | * Kapasitas dan kemampuan. Manajemen data center juga tentang perencanaan untuk masa depan. Alat manajemen dapat mengawasi kapasitas saat ini -- yaitu, sumber daya yang digunakan versus sumber daya gratis -- dan membantu operator data center melacak pemanfaatan untuk merencanakan peningkatan kapasitas. Mereka juga membantu mendukung peningkatan reguler pada kemampuan pusat data, seperti pemutakhiran sistem, penyegaran teknologi, dan pengenalan teknologi pusat data baru. | |

| − | + | Manajemen adalah elemen penting dalam jaminan layanan bisnis dan service level agreements (SLA). Banyak data center terikat oleh beberapa bentuk SLA -- baik ke departemen atau divisi internal atau ke mitra bisnis dan pelanggan eksternal. Pemantauan dan pengelolaan dengan DCIM dan alat lainnya sangat penting untuk menjamin kepatuhan terhadap SLA atau mengidentifikasi pelanggaran SLA yang dapat segera diisolasi dan diperbaiki. Selain itu, pemantauan dan manajemen yang komprehensif membantu memastikan kelangsungan bisnis dan pemulihan bencana, yang dapat menjadi penting untuk kewajiban kepatuhan terhadap peraturan saat ini. | |

==Referensi== | ==Referensi== | ||

* https://www.techtarget.com/searchdatacenter/How-to-design-and-build-a-data-center | * https://www.techtarget.com/searchdatacenter/How-to-design-and-build-a-data-center | ||

Latest revision as of 08:04, 28 April 2023

Sumber: https://www.techtarget.com/searchdatacenter/How-to-design-and-build-a-data-center

Merancang data center yang efisien bukanlah hal yang mudah. Tinjau komponen fasilitas dan infrastruktur pusat data dan berbagai standar sebelum Anda mulai. Data center adalah pusat teknologi operasi perusahaan modern. Pusat data menyediakan infrastruktur TI penting yang diperlukan untuk memberikan sumber daya dan layanan kepada karyawan bisnis, mitra, dan pelanggan di seluruh dunia.

Bisnis kecil atau menengah seringkali dapat mengimplementasikan "data center" yang berguna dalam batas-batas lemari atau ruangan nyaman lainnya dengan sedikit modifikasi, jika ada. Namun, skala besar yang terlibat dalam komputasi perusahaan menuntut ruang khusus yang besar yang dirancang dengan hati-hati untuk mendukung kebutuhan ruang, daya, pendinginan, manajemen, keandalan, dan keamanan infrastruktur TI.

Akibatnya, fasilitas data center mewakili aset tunggal terbesar dan termahal yang akan dimiliki bisnis -- baik dalam hal investasi modal maupun biaya operasional berulang. Para pemimpin bisnis dan TI harus memperhatikan masalah yang terlibat dalam desain dan konstruksi data center untuk memastikan bahwa fasilitas yang dihasilkan memenuhi kebutuhan bisnis sepanjang siklus hidup fasilitas dan keadaan bisnis yang berubah.

Apa komponen utama data center?

Ada dua aspek utama untuk data center mana pun: fasilitas, dan infrastruktur TI yang berada di dalam fasilitas. Aspek-aspek ini hidup berdampingan dan bekerja sama, tetapi dapat didiskusikan secara terpisah.

Fasilitas. Fasilitas adalah bangunan fisik yang digunakan untuk data center. Dalam istilah paling sederhana, data center hanyalah ruang terbuka besar tempat infrastruktur akan digunakan. Meskipun hampir semua ruangan memiliki potensi untuk mengoperasikan sejumlah infrastruktur TI, fasilitas yang dirancang dengan baik mempertimbangkan berbagai faktor berikut:

- Space. Harus ada ruang lantai yang cukup -- ukuran meter persegi -- untuk menampung semua infrastruktur TI yang ingin diterapkan bisnis saat ini dan di masa mendatang. Ruang harus terletak di situs yang dipertimbangkan dengan baik dengan pajak dan akses yang terjangkau. Ruang sering dibagi untuk mengakomodasi berbagai tujuan atau jenis penggunaan.

- Power. Harus ada daya yang memadai -- dalam watt, seringkali sebanyak 100 megawatt -- untuk mengoperasikan semua infrastruktur TI. Listrik harus terjangkau, bersih -- artinya bebas dari fluktuasi atau gangguan -- dan dapat diandalkan. Daya terbarukan dan tambahan/tambahan harus disertakan.

- Cooling. Sejumlah besar daya yang dikirimkan ke pusat data diubah menjadi komputasi -- yaitu, kerja -- dan banyak panas, yang harus dihilangkan dari infrastruktur TI menggunakan sistem HVAC konvensional, serta teknologi pendinginan nonkonvensional lainnya.

- Security. Mempertimbangkan nilai pusat data dan kepentingan kritisnya bagi bisnis, pusat data harus menyertakan akses terkontrol menggunakan berbagai taktik, mulai dari akses badge karyawan hingga pengawasan video.

- Management. Pusat data modern biasanya menggabungkan building management system (BMS) yang dirancang untuk membantu pemimpin TI dan bisnis mengawasi lingkungan pusat data secara real time, termasuk pengawasan suhu, kelembapan, tingkat daya dan pendinginan, serta pencatatan akses dan keamanan.

Infrastruktur. Infrastruktur mewakili rangkaian peralatan TI yang luas yang digunakan di dalam fasilitas. Ini adalah peralatan yang menjalankan aplikasi dan memberikan layanan kepada bisnis dan penggunanya. Infrastruktur TI tipikal mencakup komponen-komponen berikut:

- Server. Komputer ini menghosting aplikasi perusahaan dan melakukan tugas komputasi.

- Storage. Subsistem, seperti larik disk, digunakan untuk menyimpan dan melindungi aplikasi dan data bisnis.

- Networking. Perlengkapan yang diperlukan untuk membuat jaringan bisnis meliputi sakelar, router, firewall, dan elemen keamanan siber lainnya.

- Cable and rack. Berkilometer kabel menghubungkan perlengkapan TI, dan rak server fisik digunakan untuk mengatur server dan perlengkapan lainnya di dalam ruang fasilitas.

- Backup power. Uninterruptible power supply (UPS), flywheel, dan sistem daya darurat lainnya sangat penting untuk memastikan perilaku infrastruktur yang teratur jika terjadi gangguan daya utama.

- Management platform. Satu atau lebih data center infrastructure management (DCIM) diperlukan untuk mengawasi dan mengelola pelaporan infrastruktur TI tentang kesehatan sistem, ketersediaan, kapasitas, dan konfigurasi.

Ketika sebuah bisnis memutuskan untuk merancang dan membangun pusat data, fokus alaminya adalah pada desain dan konstruksi fasilitas tersebut. Namun para pemimpin TI juga harus mempertimbangkan infrastruktur yang akan masuk ke fasilitas untuk memvalidasi proyek.

Bagaimana merancang data center

Tidak ada standar yang diwajibkan untuk desain atau konstruksi data center; data center dimaksudkan agar sesuai dengan kebutuhan unik bisnis secara keseluruhan, bukan sebaliknya. Namun, tujuan utama dari standar apa pun adalah untuk membangun platform yang terbaik. Bermacam-macam standar data center saat ini ada, dan bisnis dapat menggabungkan satu atau lebih standar -- atau bagian dari standar -- ke dalam proyek data center. Standar membantu memastikan perhatian yang memadai diberikan pada faktor-faktor ini, antara lain:

- desain konseptual;

- tata letak dan perencanaan ruang;

- persyaratan konstruksi bangunan;

- masalah keamanan fisik;

- bangunan internal (mekanik, listrik, pipa ledeng dan sistem kebakaran);

- operasi dan workflow; Dan

- maintenance.

Di bawah ini adalah beberapa standar desain dan infrastruktur pusat data utama:

- Uptime Institute Tier Standard. Uptime Institute Tier Standard berfokus pada desain, konstruksi, dan commissioning data center, dan digunakan untuk menentukan ketahanan fasilitas terkait dengan empat tingkat redundansi/keandalan.

- ANSI/TIA 942-B. Standar ini melibatkan perencanaan, desain, konstruksi dan komisioning perdagangan bangunan, serta proteksi kebakaran, TI, dan pemeliharaan. Ini juga menggunakan empat tingkat peringkat keandalan, yang diterapkan oleh para profesional bersertifikasi BICSI.

- EN 50600 seri. Serangkaian standar ini berfokus pada kabel IT dan desain jaringan serta memiliki berbagai konsep redundansi dan keandalan infrastruktur yang secara longgar didasarkan pada Standar Tier Uptime Institute.

- ASHRA. ASHRAE guideline -- yang tidak khusus untuk TI atau data center -- terkait dengan desain dan penerapan pemanas, ventilasi, penyejuk udara, pendingin, dan bidang terkait.

Selain itu, ada banyak variasi peraturan dan standar operasional yang dapat diterapkan pada data center. Standar peraturan termasuk HIPAA, Sarbanes-Oxley Act, SAS 70 Tipe I atau II dan Gramm-Leach-Bliley Act. Standar operasional dapat mencakup ISO 9000 untuk kualitas, ISO 14000 untuk manajemen lingkungan, ISO 27001 untuk keamanan informasi, Standar Keamanan Data Industri Kartu Pembayaran untuk keamanan kartu pembayaran dan EN 50600-2-6 tentang manajemen dan informasi operasional.

Standar membantu memastikan desain, konstruksi, dan pengoperasian data center yang tepat. Selain itu, penerapan dan dokumentasi yang cermat atas penggunaan standar yang relevan dapat membantu bisnis memastikan kepatuhan yang memadai melalui ketahanan fasilitas, manajemen, dan persiapan kelanjutan bisnis yang tepat.

Ruang fisik dan organisasi data center

Pada intinya, fasilitas data center tidak lebih dari ruang terbuka yang besar -- sebuah gudang yang disiapkan dengan hati-hati yang dimaksudkan untuk menjadi tuan rumah dan mengoperasikan infrastruktur TI yang menuntut. Meskipun data center kelas perusahaan dapat menjadi pekerjaan yang besar dan kompleks, masalah utamanya adalah masalah ruang sederhana yang dinyatakan dalam meter persegi.

Mungkin masalah ruang yang paling signifikan dan membingungkan adalah ukuran data center yang tepat untuk bisnis. Data Center sangat mahal: terlalu kecil, dan data center mungkin tidak memenuhi kebutuhan bisnis saat ini atau di masa depan; terlalu besar, dan modal yang sangat besar dapat disia-siakan untuk menyediakan ruang yang tidak terpakai. Sangat penting untuk membangun fasilitas yang menawarkan kapasitas pertumbuhan namun pemanfaatan yang optimal. Ukuran data center terkadang dianggap sebagai seni tersendiri. Banyak faktor lain yang perlu dipertimbangkan dalam data center termasuk yang berikut:

- Lighting. Sebagian besar pencahayaan data data redup atau mati tanpa kehadiran manusia.

- Suhu. Tuntutan pendinginan dapat menjaga suhu tetap rendah, sehingga manusia mungkin membutuhkan pakaian pelindung.

- Noise. Kipas pendingin di lusinan -- bahkan ratusan -- server dapat menghasilkan hiruk-pikuk yang membutuhkan perlindungan pendengaran.

- Berat. Peralatan berat, dan lantai harus dirancang untuk menahan beban yang ekstrim. Pertimbangan berat khusus mungkin diperlukan untuk lantai yang ditinggikan yang digunakan untuk menangani aliran udara pendingin.

Di luar ruang fisik, desain data center harus menyertakan pertimbangan cermat terhadap lokasi dan tata letak peralatan -- yaitu, di mana infrastruktur TI ditempatkan di dalam fasilitas. Fitur paling umum dari setiap tata letak data center adalah rak server -- atau, singkatnya, rak. Rak adalah rangka logam kosong dengan opsi penspasian dan pemasangan standar yang dimaksudkan untuk menampung perlengkapan TI yang dipasang di rak standar, seperti server, subsistem penyimpanan, perlengkapan jaringan, pemasangan kabel, sistem daya tambahan seperti perangkat UPS, dan opsi I/O seperti keyboard dan monitor untuk akses administratif.

Rak juga memainkan peran penting dalam skema pendinginan data center. Rak roda gigi umumnya diatur untuk membuat lorong panas dan dingin yang dapat meningkatkan efisiensi pendinginan dengan memungkinkan masuknya udara dingin ke lorong dingin, yang dipanaskan oleh roda gigi dan dikirim ke lorong panas, di mana udara panas dapat dihilangkan secara efektif dari ruangan. Pengaturan lorong juga dapat membantu memfasilitasi pengenalan pintu tambahan dan langkah-langkah keamanan di ujung setiap lorong untuk membatasi akses manusia.

Keamanan data center

Keamanan data center biasanya melibatkan tiga aspek berbeda yaitu keamanan akses, keamanan fasilitas, dan keamanan siber.

Akses keamanan. Setiap pembahasan fasilitas data center harus melibatkan pertimbangan keamanan fisik. Keamanan fisik adalah pengelolaan personel manusia dan perlindungan fasilitas fisik serta infrastruktur TI-nya. Ketika diterapkan dengan benar, keamanan memastikan bahwa hanya personel yang berwenang yang memiliki akses ke fasilitas dan perlengkapan, dan bahwa semua aktivitas manusia didokumentasikan. Keamanan dapat melibatkan serangkaian tindakan berikut:

- akses badge ke dalam dan di sekitar fasilitas (termasuk area peralatan);

- akses kunci ke rak dan server tertentu;

- log untuk akses karyawan dan pengunjung/vendor;

- pendamping untuk non-karyawan;

- CCTV; Dan

- petugas keamanan di tempat.

Keamanan fasilitas. Keamanan fisik juga mencakup integritas lingkungan data center, termasuk suhu, kelembapan, dan kondisi asap/kebakaran/banjir. Aspek perlindungan data center ini sering ditangani oleh BMS yang memantau dan melaporkan kondisi lingkungan atau darurat kepada pengelola gedung.

Keamanan cyber. Cybersecurity berfokus pada pengendalian akses ke data perusahaan dan aplikasi yang dihosting dalam infrastruktur TI data center. Cybersecurity dimaksudkan untuk memastikan bahwa hanya pengguna yang diautentikasi dengan benar yang dapat mengakses data atau menggunakan aplikasi, dan setiap pelanggaran dilaporkan dan segera ditangani. Misalnya, keamanan fisik mencegah manusia menyentuh disk di pusat data, sementara keamanan siber mencegah manusia yang sama mengakses data di disk dari jarak ratusan mil di seluruh jaringan. Cybersecurity menggunakan campuran antimalware, manajemen konfigurasi, deteksi/pencegahan intrusi, pencatatan aktivitas, dan alat lain untuk mengawasi aktivitas jaringan dan mengidentifikasi potensi ancaman.

Data center power and performance demands

Power is a perpetual challenge for any enterprise-class data center. A large facility can consume about 100 megawatts -- enough to power around 80,000 homes -- and power poses the single biggest Opex for an enterprise-class data center. Therefore, data center operators place the following demands on utility power:

- Capacity. There must be adequate power to run the data center.

- Cost. Power must be as inexpensive as possible.

- Quality. Power must be electrically clean (i.e., free of undesirable electrical noise, surges and spikes).

- Reliability. Power must be free of brownouts, blackouts or other disruptions.

These issues are increasingly addressed with locally generated and increasingly renewable options, including wind, solar and on-site generation.

But for a business to understand power issues for any data center site, it's important that data center designers and IT leaders calculate the power demands of the facility and its IT infrastructure. It's this benchmark that enables a business to understand approximate power costs and discuss capacity with regional utilities.

There is no single means of estimating power requirements. For the facility, power is a straightforward estimate of lighting and HVAC demands. IT infrastructure power demands can be more convoluted because server power requirements fluctuate with workload -- i.e., how much work the applications are doing -- and the configuration of each server, including the selection of CPU, installed memory and other expansion devices, such as GPUs.

Traditional power estimates include rack-based and nameplate-based approaches.

The rack-based approach generally assigns a standardized power-per-rack estimate. For example, an IT leader might assign an estimate of 7 kW to 10 kW per rack. If the data center plans to deploy 50 racks, the power estimate is a simple multiple. A similar approach is a general estimate of data center in watts per square foot (W/ft2). However, since this approach pays little attention to the equipment installed in each rack, it is often the most inaccurate means of power estimation.

The nameplate-based approach enables IT leaders to add up the power requirement listed on the nameplate of each server or other IT device. This is a more granular approach and can typically yield better estimates. Still, the power demand listed on each device nameplate can be notoriously inaccurate and doesn't consider the actual work the device is doing.

A more recent approach is to use actual power measurements per server, taken with IT power-handling devices, such as intelligent power distribution units (PDUs), located within each rack. Actual measurements can yield the most accurate estimates and give data center operators a better sense of how power demands and costs can fluctuate with workload demands.

Finally, utility power will inevitably experience occasional disruptions in generation and distribution, so data centers must include one or more options for redundant or backup power. There can be several layers of secondary power put in place, depending on which issues the business intends to guard against.

At the facility level, a data center can incorporate diesel or natural gas-powered backup generators capable of running the entire facility over the long term. Backup power can be supplemented by local renewable energy sources, such as solar or wind farms. At the IT infrastructure level, racks can incorporate UPS options, which provide short-term battery backups to enable an orderly system shutdown when power disruptions become unavoidable.

UPS under normal power diagram A full-time double conversion UPS design under normal utility power. UPS during power failure diagram A dual conversion UPS design when utility power fails.

Data center cooling system

Daya yang dialirkan ke data center diterjemahkan ke dalam pekerjaan yang dilakukan oleh infrastruktur TI, serta produk sampingan yang tidak diinginkan: panas. Panas ini harus dihilangkan dari server dan sistem, dan kemudian dikeluarkan dari data center. Akibatnya, sistem pendingin menjadi perhatian penting bagi perancang dan operator data center.

Ada dua masalah pendinginan utama. Masalah pertama adalah jumlah pendinginan yang diperlukan, yang pada akhirnya menentukan ukuran atau kapasitas subsistem HVAC pusat data. Namun, perancang harus membuat terjemahan dari permintaan daya data center dalam watt (W) ke kapasitas pendinginan yang diukur dalam ton (t) -- yaitu, jumlah energi panas yang dibutuhkan untuk melelehkan satu ton es pada suhu 0 derajat Celsius (32 derajat Fahrenheit) dalam satu jam . Perhitungan tipikal pertama membutuhkan konversi watt menjadi British thermal unit (BTU) per jam, yang kemudian dapat dikonversi menjadi ton:

W x 3.41 = BTU/hour

BTU/hour / 12,000 = t

Kuncinya adalah memahami kebutuhan daya data center dalam watt dan skalabilitas terencana, jadi penting untuk mengukur subsistem pendingin gedung dengan ukuran yang tepat. Jika sistem pendingin terlalu kecil, data center tidak dapat menampung atau menskalakan jumlah infrastruktur TI yang diharapkan. Jika sistem pendingin terlalu besar, hal itu menimbulkan utilitas yang mahal dan tidak efisien untuk bisnis.

Masalah pendinginan kedua untuk data center adalah penggunaan dan penanganan udara dingin dan panas yang efisien. Untuk ruang manusia biasa, hanya memasukkan udara dingin dari satu ventilasi dan kemudian membuang udara hangat dari ventilasi lain di tempat lain di ruangan itu menyebabkan pencampuran dan rata-rata suhu yang menghasilkan kenyamanan manusia yang memadai. Tapi pendekatan rumah dan kantor yang umum ini tidak bekerja dengan baik di data center, di mana rak peralatan menghasilkan panas yang ekstrim di ruang yang terkonsentrasi. Rak gigi yang sangat panas membutuhkan aplikasi udara dingin yang hati-hati, dan kemudian dengan hati-hati menahan dan membuang knalpot yang panas. Perancang data center harus berhati-hati untuk menghindari pencampuran udara panas dan dingin yang membuat ruang ber-AC manusia begitu nyaman.

Desainer secara rutin mengatasi penanganan udara ruang server melalui penggunaan skema penahanan, seperti tata letak lorong panas/dingin. Pertimbangkan dua baris rak peralatan, di mana bagian belakang saling berhadapan (lihat diagram kedua di bawah). Udara dingin dari sistem HVAC dimasukkan ke lorong di depan setiap baris rak, sementara udara panas dikumpulkan dan dibuang dari lorong panas umum. Penghalang fisik tambahan ditambahkan untuk mencegah udara panas bercampur dengan udara dingin. Skema penahanan tersebut menawarkan penggunaan kapasitas HVAC yang sangat efisien.

Pendekatan lain untuk pendinginan termasuk sistem pendingin udara ujung baris dan atas rak, yang memasukkan udara dingin ke bagian-bagian dari deretan rak dan membuang udara panas ke lorong panas.

Beberapa data center bahkan mengadopsi teknologi pendingin cair baru yang menenggelamkan peralatan TI dalam bak berisi cairan dingin yang netral secara elektrik, seperti minyak mineral. Chiller cair berukuran kecil dan hemat daya, dan cairan dapat menawarkan efisiensi perpindahan panas berkali-kali lipat dibandingkan pendinginan udara. Namun, pendinginan cair menghadapi tantangan lain, termasuk kebocoran/banjir, korosi sebagian atau kerentanan terhadap intrusi cairan, penyaringan dan kebersihan cairan, dan keselamatan manusia.

Diagram ini menunjukkan konsep dasar arsitektur pendinginan berbasis ruangan, baris, dan rak. Panah biru menunjukkan hubungan jalur pasokan pendingin utama ke ruangan.

Data center efficiency and sustainability

Kekhawatiran saat ini tentang dampak lingkungan dari emisi CO2 dari pembangkit listrik telah mendorong banyak organisasi untuk memberikan penekanan baru pada efisiensi dan keberlanjutan data center.

Efisiensi pada dasarnya adalah ukuran kerja yang dilakukan versus jumlah energi yang digunakan untuk melakukan kerja itu. Jika semua energi input berhasil diubah menjadi kerja yang bermanfaat, efisiensinya adalah 100%. Jika tidak ada energi input yang menghasilkan kerja yang berhasil, efisiensinya adalah 0%. Bisnis berupaya meningkatkan efisiensi hingga 100% sehingga setiap dolar yang dihabiskan untuk energi mendorong pekerjaan data center yang bermanfaat.

Tindakan seperti power usage effectiveness (PUE) tersedia untuk membantu organisasi mengukur efisiensi. PUE dihitung sebagai daya yang masuk ke pusat data dibagi dengan daya yang digunakan dalam infrastruktur TI. Ini menghasilkan rasio sederhana yang mendekati 1,0 saat efisiensi mendekati 100%, dan persentase yang sesuai dinyatakan sebagai efisiensi infrastruktur pusat data. Bisnis dapat meningkatkan rasio PUE dengan mengurangi jumlah energi dalam penggunaan non-IT, seperti mengurangi pencahayaan dan pendinginan di ruang non-IT dan menerapkan desain bangunan hemat energi lainnya.

Keberlanjutan adalah perhatian lain. Pembangkit listrik menciptakan polusi yang diyakini mendorong perubahan iklim dan mengurangi kesehatan planet ini. Menciptakan data center yang berkelanjutan atau hijau berarti mengupayakan emisi karbon nol bersih untuk daya yang menggerakkan pusat data. Nol bersih berarti energi diperoleh dari sumber terbarukan yang menambahkan nol CO2 ke atmosfer.

Dalam beberapa kasus, bisnis dapat memilih untuk mendekati nol bersih dengan menggunakan daya dari sumber yang tidak mencemari, seperti pembangkit tenaga surya atau angin. Dalam kasus lain, daya dapat dibeli dari penyedia daya yang mampu menangkap atau memulihkan jumlah setara CO2 yang dipancarkan dalam produksi energi, sehingga menghasilkan emisi nol bersih. Untuk mencapai net zero, bisnis harus menerapkan konservasi energi, efisiensi energi -- seperti inisiatif PUE -- dan sumber energi terbarukan tanpa polusi.

Kurangi konsumsi energi penyimpanan data untuk menjalankan data center yang lebih ramah lingkungan.

Data center design best practice

Tidak ada cara tunggal untuk merancang sebuah data center, dan ada banyak sekali desain yang memenuhi kebutuhan unik setiap bisnis. Tetapi strategi berikut dapat menghasilkan desain data center dengan efisiensi dan keberlanjutan yang unggul:

- Measure power efficiency. Operator pusat data tidak dapat mengelola apa yang tidak mereka ukur, jadi gunakan metrik seperti PUE untuk mengawasi efisiensi data center. PUE harus menjadi pengukuran berkelanjutan yang dilakukan pada interval yang sering, sepanjang tahun, karena musim dan cuaca dapat memengaruhi penggunaan daya.

- Revisit airflow. Pendinginan sangat penting untuk pengoperasian infrastruktur TI yang aman, tetapi aliran udara harus dikelola dan dioptimalkan. Ini dapat mencakup pembatasan pencampuran udara panas/dingin, menggunakan skema penahanan lorong panas/dingin dan bahkan menggunakan pelat blanking untuk menutup bukaan rak yang tidak terpakai, yang mencegah udara dingin mengalir ke tempat yang tidak mendinginkan peralatan apa pun.

- Raise the temperature. Semakin dingin ruang server, semakin haus daya dan mahal. Daripada menjaga ruang server lebih dingin, evaluasi efek dari menaikkan suhu sebenarnya. Misalnya, daripada menjalankan lorong dingin pada suhu 16 hingga 22 derajat Celsius, pertimbangkan menjalankan lorong dingin pada suhu 25 hingga 27 derajat Celsius. Sebagian besar perlengkapan IT dapat mentolerir suhu tinggi dengan cara ini.

- Try alternative cooling. Sistem HVAC mungkin standar untuk pusat data, tetapi pertimbangkan cara untuk mengurangi atau menghilangkan ketergantungan pada HVAC konvensional. Misalnya, data center di iklim yang lebih dingin dapat mengurangi penggunaan HVAC dan memasukkan udara luar yang lebih sejuk -- disebut pendinginan gratis -- ke dalam fasilitas. Demikian pula, HVAC dapat dilengkapi atau diganti dengan pendingin berpendingin air - yaitu, economizers - atau teknologi pertukaran panas lainnya yang menggunakan energi jauh lebih sedikit.

- Improve power distribution. Efisiensi daya data center sering kali hilang karena inefisiensi dalam penanganan daya dan perangkat distribusi, seperti transformator peralatan, PDU, dan perlengkapan UPS. Gunakan roda gigi distribusi daya berefisiensi tinggi dan minimalkan roda gigi -- keduanya menghasilkan langkah yang lebih sedikit dan peluang kehilangan.

Tantangan desain data center

Meskipun tidak ada formula tunggal yang seragam untuk desain dan konstruksi data center, ada banyak tantangan abadi yang dihadapi oleh perancang dan operator data center. Di bawah ini adalah beberapa pertimbangan dan tantangan yang luas:

- Scalability. Data center adalah instalasi jangka panjang yang dapat tetap beroperasi selama beberapa dekade, tetapi data center yang beroperasi saat ini mungkin berbeda secara signifikan dari data center yang beroperasi satu atau dua dekade dari sekarang. Desainer harus mempertimbangkan cara menangani beban kerja dan layanan saat ini, sambil juga mempertimbangkan bagaimana sumber daya tersebut harus diskalakan dengan baik ke masa depan. Tantangannya adalah menyediakan ruang untuk pertumbuhan ruang, daya, dan pendinginan sambil mengurangi biaya kapasitas tersebut hingga dibutuhkan.

- Flexibility. Pusat data sedikit mirip dengan lantai produksi yang berat: Peralatan sudah terpasang tetapi hampir tidak mungkin untuk dipindahkan dan diubah seiring berkembangnya permintaan. Ketidakmampuan untuk memindahkan gigi dan menggeser lorong dapat mencegah bisnis beradaptasi dan berubah untuk memenuhi permintaan bisnis baru. Tantangannya adalah memenuhi kebutuhan akan perubahan tanpa downtime atau desain ulang yang mahal dan memakan waktu.

- Resilience. Sebuah bisnis bergantung pada data center-nya. Jika data center tidak berfungsi, bisnis tidak berfungsi. Gangguan listrik, gangguan jaringan, bencana lingkungan dan bahkan peretasan dan tindakan jahat lainnya dapat melumpuhkan data center. Desainer menghadapi tantangan untuk memahami ancaman yang paling umum dan merancang ketahanan yang tepat untuk menghadapi ancaman tersebut.

- Change. Teknologi komputasi baru dan persyaratan baru selalu dikembangkan dan diperkenalkan. Perancang data center harus mempertimbangkan cara mengadaptasi dan menggabungkan perubahan yang sering tidak terduga tanpa perlu mendesain ulang infrastruktur TI secara mendasar untuk mengakomodasi setiap perubahan.

Data center infrastructure management software and tool

Data center adalah organisme kompleks yang memerlukan pemantauan dan manajemen berkelanjutan baik di tingkat fasilitas maupun infrastruktur TI. Operator data center biasanya menggunakan alat DCIM untuk memberikan perspektif ke dalam pengoperasian fasilitas dan infrastruktur. Serangkaian tugas manajemen umum yang diperlukan untuk mengoperasikan data center mencakup hal-hal berikut:

- Pengamatan dan pengawasan. Tugas observasi meliputi pemantauan daya, suhu dan kelembaban di dalam fasilitas. Pengamatan dalam infrastruktur dapat mencakup kapasitas yang tersedia, artinya sistem mana yang digunakan dan mana yang gratis; kesehatan aplikasi untuk memantau operasi yang benar dari beban kerja utama perusahaan; dan waktu aktif atau ketersediaan secara keseluruhan. Tugas observasi biasanya dikaitkan dengan sistem peringatan dan tiket untuk memprioritaskan dan memulihkan masalah saat terdeteksi.

- Persiapan dan perbaikan. Manajemen data center juga melibatkan tugas persiapan, seperti pemulihan bencana dan proses pencadangan, serta kemampuan migrasi beban kerja untuk memungkinkan tugas layanan sistem tepat waktu. Tugas perbaikan meliputi servis rutin, bersama dengan peningkatan sistem berkala dan pemecahan masalah dan perbaikan sistem ad hoc.

- Kapasitas dan kemampuan. Manajemen data center juga tentang perencanaan untuk masa depan. Alat manajemen dapat mengawasi kapasitas saat ini -- yaitu, sumber daya yang digunakan versus sumber daya gratis -- dan membantu operator data center melacak pemanfaatan untuk merencanakan peningkatan kapasitas. Mereka juga membantu mendukung peningkatan reguler pada kemampuan pusat data, seperti pemutakhiran sistem, penyegaran teknologi, dan pengenalan teknologi pusat data baru.

Manajemen adalah elemen penting dalam jaminan layanan bisnis dan service level agreements (SLA). Banyak data center terikat oleh beberapa bentuk SLA -- baik ke departemen atau divisi internal atau ke mitra bisnis dan pelanggan eksternal. Pemantauan dan pengelolaan dengan DCIM dan alat lainnya sangat penting untuk menjamin kepatuhan terhadap SLA atau mengidentifikasi pelanggaran SLA yang dapat segera diisolasi dan diperbaiki. Selain itu, pemantauan dan manajemen yang komprehensif membantu memastikan kelangsungan bisnis dan pemulihan bencana, yang dapat menjadi penting untuk kewajiban kepatuhan terhadap peraturan saat ini.